常见计算机基础

编码和加密

1.摘要算法

摘要

- 摘要是哈希值,我们通过散列算法比如 MD5 算法就可以得到这个哈希值。

- 摘要只是用于验证数据完整性和唯一性的哈希值,不管原始数据是什么样的,得到的哈希值都是固定长度的。

- 不管原始数据是什么样的,得到的哈希值都是固定长度的,也就是说摘要并不是原始数据加密后的密文,只是一个验证身份的令牌。所以我们无法通过摘要解密得到原始数据。

加密

加密是通过 “加密算法” 将 "明文" 加密成 “密文”。 我们可以通过 “密钥” 和 “解密算法” 将 “密文” 还原成 “明文”。

MD5 算法

MD5 算法就是一种常见的摘要算法。该算法可以生成压缩包的一个 128 bit 的二进制串。除了压缩包,也可以应用于其他文件和字符串。比如数据库中不会直接存储账号密码,比如我就习惯将 密码拼接一个无规律的字符串 然后计算出 MD5 摘要放入数据库中

特点

MD5的主要特点有:长度固定、计算简单、抗修改性以及强抗碰撞性。

- 长度固定:

MD5加密后值固定长度是 128 位,使用 32 个 16 进制数字进行表示。 - 计算简单:

MD5加密采用的是散列算法(哈希算法),进行MD5计算时简单易得,加密速度快。 - 抗修改性:

MD5值是 16 进制数,当修改原数据的 1 个字节,所代表MD5值也是截然不同,只要有任何改动都能够察觉。 - 强抗碰撞性:碰撞性就是通过

MD5加密算法得到MD5值中与其它明文加密得到的MD5值相同的概率。强抗碰撞性指要找到散列值相同的两条不同的消息是非常困难的,得到相同MD5的概率低。

原理

- 填充数据:首先将输入的数据长度(

bit)进行 512 求余,如果取余得到结果不等于 448,则对其进行填充bit使其取余结果 448。具体填充方式是在其第一位 bit 填充 1,其余 N 位bit进行补 0,这样得到的数据长度为 512*N+448。 - 记录数据长度:其次将填充前的数据长度用 64 位进行存储,而后将其追加在填充后的数据后面,使其数据长度为 N×512+448+64=(N+1)×512bit。

- 装入标准幻数:其实就是将 128bit 的 MD5 值按照每 32bit 就是一个标准幻数,可以得到四个标准幻数

A=01234567、B=89ABCDEF、C=FEDCBA98以及D=76543210。 - 四轮循环运算:上面数据处理后的数据长度是(N+1)/512,按照每 512 位(64 字节)作为一块,总共要循环 N+1 次,并将块细分为 16 个小组,每组的长度为 32 位(4 字节),这 16 个小组即为一轮,总共得循环 4 轮,即 64 次循环。总的来说我们需要

(N+1)个主循环,每个主循环包含了 64 次子循环,来不断的改变幻数 A,B,C,D 才能最终得到数据的 MD5 值。

SHA-1 算法也是一种哈希算法,输出 160bit,它的同类型算法有 SHA-256 和 SHA-512,输出的长度分别是 256bit 和 512bit

2.base64 编码

我们的图片大部分都是可以转换成 base64 编码的 data:image。 这个在将 canvas 保存为 img 的时候尤其有用。现代浏览器都已经支持原生的基于 base64 的 encode 和 decode,例如btoa和atob

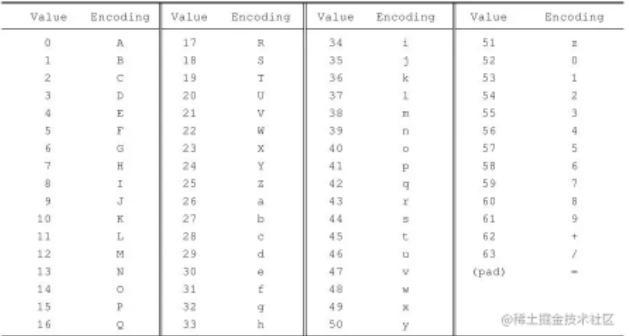

看一下 Base64 的索引表,字符选用了"A-Z、a-z、0-9、+、/" 64 个可打印字符。数值代表字符的索引,这个是标准 Base64 协议规定的,不能更改。64 个字符用 6 个 bit 位就可以全部表示,一个字节有 8 个 bit 位,剩下两个 bit 就浪费掉了,这样就不得不牺牲一部分空间了。这里需要弄明白的就是一个 Base64 字符是 8 个 bit,但是有效部分只有右边的 6 个 bit,左边两个永远是 0。

那么怎么用 6 个有效 bit 来表示传统字符的 8 个 bit 呢?8 和 6 的最小公倍数是 24,也就是说 3 个传统字节可以由 4 个 Base64 字符来表示,保证有效位数是一样的,这样就多了 1/3 的字节数来弥补 Base64 只有 6 个有效 bit 的不足。

将原数据每 6 位对应成 Base 64 索引表中的⼀个字符编排成⼀个字符串(每个字符 8 位)

你也可以说用两个 Base64 字符也能表示一个传统字符,但是采用最小公倍数的方案其实是最减少浪费的。结合下边的图比较容易理解。Man 是三个字符,一共 24 个有效 bit,只好用 4 个 Base64 字符来凑齐 24 个有效位。红框表示的是对应的 Base64,6 个有效位转化成相应的索引值再对应 Base64 字符表,查出"Man"对应的 Base64 字符是"TWFU"。

说到这里有个原则不知道你发现了没有,要转换成 Base64 的最小单位就是三个字节,对一个字符串来说每次都是三个字节三个字节的转换,对应的是 Base64 的四个字节。这个搞清楚了其实就差不多了。

但是转换到最后你发现不够三个字节了怎么办呢?愿望终于实现了,我们可以用两个 Base64 来表示一个字符或用三个 Base64 表示两个字符,像下图的 A 对应的第二个 Base64 的二进制位只有两个,把后边的四个补 0 就是了。所以 A 对应的 Base64 字符就是 QQ。

上边已经说过了,原则是 Base64 字符的最小单位是四个字符一组,那这才两个字符,后边补两个"="吧。其实不用"="也不耽误解码,之所以用"=",可能是考虑到多段编码后的 Base64 字符串拼起来也不会引起混淆。由此可见 Base64 字符串只可能最后出现一个或两个"=",中间是不可能出现"="的。下图中字符"BC"的编码过程也是一样的。

Base64 编码的过程如下:

- (1)首先对待编码字符串进行每 3 个字节分组,如果当前分组不够 3 个字节,则通过补零来构成 3 字节一组。

- (2)将每组的 24 位按照 6 位划分,得到 4 个 6 位二进制数组。

- (3)对每个 6 位二进制数组进行高位补零,形成 8 位二进制数数组。

- (4)查表获取每个字节的十进制对应的字符。

- (5)将(1)中补充的字节数兑换成 = 的个数,拼接到(4)得到的完整字符串的尾部。

总结

说起 Base64 编码可能有些奇怪,因为大多数的编码都是由字符转化成二进制的过程,而从二进制转成字符的过程称为解码。而 Base64 的概念就恰好反了,由二进制转到字符称为编码,由字符到二进制称为解码。

Base64 编码主要用在传输、存储、表示二进制等领域,还可以用来加密,但是这种加密比较简单,只是一眼看上去不知道什么内容罢了,当然也可以对 Base64 的字符序列进行定制来进行加密。

Base64 编码是从二进制到字符的过程,像一些中文字符用不同的编码转为二进制时,产生的二进制是不一样的,所以最终产生的 Base64 字符也不一样。例如"上网"对应 utf-8 格式的 Base64 编码是"5LiK572R",对应 GB2312 格式的 Base64 编码是"yc/N+A=="。

3.字符编码理论

1. 字符集(Character set)

字符类似 a,b,你,&等各种文字和符号的总称,包括各国家文字、标点符号、图形符号、数字,emoji 等是一个字符。而字符的集合就称之为字符集。我们常见字符集有 ASCCII 字符集、Unicode 字符集、GBK 字符集等。

ASCCII 字符集 主要包括控制字符(回车键、退格、换行键等);可显示字符(英文大小写字符、阿拉伯 数字和西文符号)。

Unicode 字符集 ASCCII 具有很大的局限性,只能表示至多 127 个字符,而诸如汉字,阿拉伯语等都有自己的文字字符,ASCCII 字符集是不能表示的。Unicode 字符集可以简单的理解为通用所有字符的一个集合。

每个字符对应一个数字,每个数字对应一个字符,而这个数字也称之为码点。根据码点就可以字符集中索引到对应的字符。

2. 字符编码

计算机系统中所有的数据都是用二进制进行传输和存储的,当然字符也不例外。把一个数值与字符集中的字符进行匹配建立一一对应关系的规则称之为字符编码。跟我们差字典一样,同一本字典(编码)第几页第几个字(字符)就能确定唯一一个字符。通常来讲,每一个字符在字符集中都有一个码点,我们对根据码点就能确认一个字符,我们对码点就行储存和编码就能达到对字符进行传输和存储的目的。

2.1. UTF-8

UTF-8(8-bit Unicode Transformation Format)是一种针对 Unicode 的可变长度字符编码,也是一种前缀码。它可以用来表示 Unicode 标准中的任何字符,且其编码中的第一个字节仍与 ASCII 兼容。

UTF-8 是一种变长的字符编码,一个字符的 UTF-8 编码可能占 1-4 个字节,而占某个字符具体占几个字节取决,字符码点的值。

具体表示的时候,

- 如果第一个字节的第一 bit 为 0,表示当前字符只用一个字节就可以表示。具体的码点值,就是当前字节除 0 位之外其他 7 个字节。

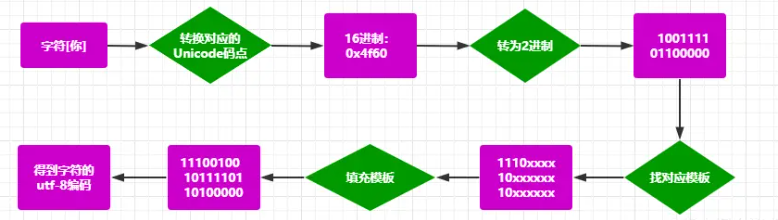

- 如果第一个字节的第一个 bit 不为 0,则从开头知道碰到第一个 0 的过程中有几个 1,就用几个字节表示。好像描述的不太好,看图更明了。如下图

Unicode符号范围(码点范围) | UTF-8编码模板

(十六进制) | (二进制)

---------------------------+---------------------------------------------

0000 0000-0000 007F | 0xxxxxxx |可用7bit

0000 0080-0000 07FF | 110xxxxx 10xxxxxx |可用11bit

0000 0800-0000 FFFF | 1110xxxx 10xxxxxx 10xxxxxx |可用16bit

0001 0000-0010 FFFF | 11110xxx 10xxxxxx 10xxxxxx 10xxxxxx |可用21bit

上表表示如何从一个从 Unicode 转化到 UTF-8

对于任意字符,UInicode 码点的值,在上表中找到对应的编码模板,然后把码点值转换为 2 进制,依次从后往前填入码位(上表中的 x),不足的用 0 补齐。

比如 :[你] 这个字的 Unicode 编码是 0x4f60。0x6C49 在 0x0800-0xFFFF 之间,使用 3 字节模板:1110xxxx 10xxxxxx 10xxxxxx。将 ox4f60 写成二进制是: 1001111 01100000 , 从这个二进制值从低到高取出比特,从模板的低位到高位替换模板中的 x 的位置,不足的用 0 补齐,得到:11100100 10111101 10100000。可见[你]这个字符 utf-8 编码占 3 个字节

3. URL

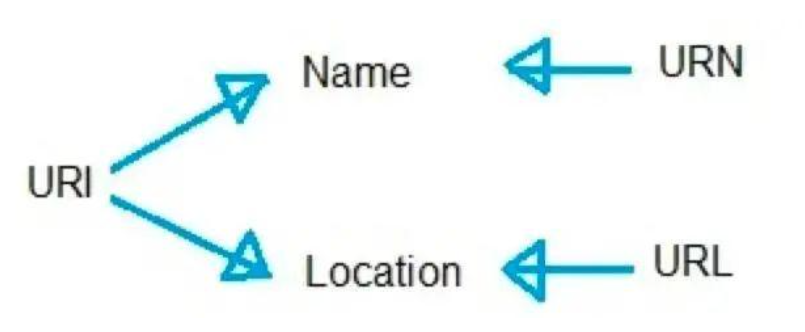

URi 和 URL 和 URN 之间的关系

URi

uri 的全称为:uniform resource identifier,中文为统一资源标识符,用来表示唯一的标识资源。web 上可用的每一种资源,例如 html 文档,图像,视频片段,程序等都是由一个通用资源标识符进行定位。

uri 组成

1、访问资源的命名机制 2、存放资源的主机名 3、资源自身的名称,由路由表示

我们以http://www.baidu.com/index.html为例:

这个 uri 是这样的:这是一个 http 协议访问的资源,位于www.baidu.com主机上,通过路径/index.html来进行访问。

绝对 uri

uri 存在绝对 uri 和相对 uri 之分,绝对 uri 指的是 scheme(后面跟着冒号)开头的 uri。前面的http://www.baidu.com/index.html就是一个绝对的uri。还存在其他的例子:mailto:jeff@javajeff.com.等等到时绝对的uri.

相对的 uri

相对的 uri 不含任何命名规则。它的路径通查指同一台机器上的资源。

例如:<img src="../icons/logo.png">就是相对的uri。

在 html 中,uri 被用来 1、链接到另一个文档或资源 2、链接到一个外部样式表或者脚本 3、在页内包含图形等

URL

url 是 uniform resource locator,指的是统一资源名称,它是一种具体的 uri,即 url 可以用来标识一个资源。

1、internet 资源类型,指出 www 客户程序用来操作的工具。 2、服务器地址(host):指出 www 网页所在的服务器域名。必需的。 3、端口(port):有时(并非总是这样),对某些资源的访问来说,需给出相应的服务器提供端口。可选的。 4、路径:指明服务器上某资源的位置。与端口一样,路径并非总是需要的,可选。

URN

URN:uniform resource name,统一资源命名,是通过名字来标识,比如

mailto:java-net@java.sun.comURN 可以理解为通过名称来标识位置。但是其流行还需要假以时日,因为他需要更精密软件支持。

关系

uri 是统一资源标识符,用来唯一确定资源,他是一种抽象,也就是说不管用什么方法,只要可以唯一确定资源,那么那就是 uri。

url:统一资源定位符,urn:统一资源名称。 url 和 urn 是 uri 的子集,url 可以理解为用地址来定位资源,urn 可以理解为用名称来定位资源。

3.1. URL 格式

统一资源定位符的完整格式如下:

foo://example.com:8042/over/there?name=ferret#nose

\_/ \______________/\_________/ \_________/ \__/

| | | | |

scheme authority path query fragment

| _____________________|__

/ \ / \

urn:example:animal:ferret:nose

一个完整的 URL 主要有以下部分组成这些部分被 URL 的保留字符相连。

- 协议(sheme)。

- 层级 URL 标记符号,为[//],是固定不变的

- 访问资源需要的凭证信息(authority)

- 服务器地址(host)。通常为域名,有时为 IP 地址

- 端口号(port)。以数字方式表示,若为默认值可省略

- 路径(path)。以“/”字符区别路径中的每一个路径名称

- 查询(query)。键值对参数,以“?”字符为起点,每个参数键值对以“&”隔开,再以“=”分开参数名称和值

- 片段。以“#”字符为起点

3.2. URL 中的字符

RFC 中规定,URL 中只有可显的 asscii 字符集中的字符是合法的。

URL 的字符中有特殊的含义通常用来做分隔符如

www.google.com?a=12&b=34中:/?&都为 url 中的保留字符。2005 年规定的保留字符:

! * ' ( ) ; : @ & = + $ , ? # [ ]

URL 字符中,大写字母(A-Z)、小写字母(a-z)、数字(0-9)等为非保留字符。这些字符含义只是表示字面量在协议中不允许特殊的语义。

2005 年规定的非保留字符:

A B C D E F G H I J K L M N O P Q R S T U V W X Y Z a b c d e f g h i j k l m n o p q r s t u v w x y z 0 1 2 3 4 5 6 7 8 9 - _ . ~

- URL 字符中除了保留字符和非保留字符之外的字符,比如百分号符(%),这些其他字符,允许有一些特殊的语义但是不强制。

4. URL encoding 百分号编码

4.1. 为什么要 URL encoding

- 在具体的 URL 中诸如 path 或者 query 部分,如果存在着保留字段会有语义上的不合法性。 比如:

http://www.abac.com/a/?abc=1&2&ef=24。&为保留字符,用以链接两个 query 键值对。而在这个 URL 中想要传递键为 abc 值为 1&2 的时候在语法上是不合法的。 - URL 的字符集只是 ASCII 字符集的一个字集,如果要传递 URL 合法的字符以外的字符,是没办法表示的。比如要在 url 的 path 中有"好"这个字符。

- 另,URL 字符集中的其他字符集有可能存在不安全的字符。是有一些特殊语义的。

基于以上三点,我们需要一种编码来解决 URl 使用过程中的一些歧义。来解决这个编码问题的就是 URLEncode。

4.2. URL encoding 的规则

2005 年 1 月发布的 RFC 3986

对可能会引起歧义的保留字符、不在 ASCII 码之外的字符和 URL 字符集范围内的其他字符进行 URlEncode,以保证 URL 语义的正确性。URLEncode 的规则:

- 未保留字符不需要百分号编码。比如字符 a 百分号编码后之后还是 a。

- 对保留字符的百分号编码。编码逻辑为:对应字符的 ASCII 的值表示为两个 16 进制的值,然后在其前面放置%字符。比如,保留字符?对应的 ASCII 码点值为 6(十进制)对应 16 进制为 3F,然后在 16 进制值前面加上%字符最终得到保留字符?的 url 编码为%3F。注意:对字节百分号编码后里 16 进制的表示都为大写字母比如%3F,且在 URL 编码后默认不区分大小写。

- 对于其他字符百分号编码。编码逻辑为:把对应字符用某种编码格式(如 utf-8)转为字节序列,然后把每个字节序列的值进行百分号编码。这里展开说一下,所谓的对每个字节进行编码,把每个字节的值转为 16 进制,然后再 16 进制前加百分号就得到了对应的百分号编码。

将需要转码的字符转为 16 进制,然后从右到左,取 4 位(不足 4 位直接处理),每 2 位做一位,前面加上%,编码成%XY 格式。

比如:

空格 ASCII 码是 32,对应 16 进制是 20,那么 urlencode 编码结果是:%20,但在新标准中空格对应的是+,见 RFC-1738

比如:

中 ASCII 码是-10544,对应的 16 进制是 D6D0,那么 urlencode 编码结果是:%D6%D0

4.3. URL encoding 用途

http post 形式发送时指定 Content-Type 为

application/x-www-form-urlencode时,postbody 中的键值对都会进行百分号编码以保证数据的无歧义。当我们的 http url 中,query 和 path 部分的内容如果需要被 urlencode 也要进行百分号编码,不做赘述。

4.常见加密算法

MD5 用的是 哈希函数,它的典型应用是对一段信息产生 信息摘要,以 防止被篡改。严格来说,MD5 不是一种 加密算法 而是 摘要算法。无论是多长的输入,MD5 都会输出长度为 128bits 的一个串 (通常用 16 进制 表示为 32 个字符)。

SHA1 是和 MD5 一样流行的 消息摘要算法,然而 SHA1 比 MD5 的 安全性更强。对于长度小于 2 ^ 64 位的消息,SHA1 会产生一个 160 位的 消息摘要。基于 MD5、SHA1 的信息摘要特性以及 不可逆 (一般而言),可以被应用在检查 文件完整性 以及 数字签名 等场景。

HMAC 是密钥相关的 哈希运算消息认证码(Hash-based Message Authentication Code),HMAC 运算利用 哈希算法 (MD5、SHA1 等),以 一个密钥 和 一个消息 为输入,生成一个 消息摘要 作为 输出。

HMAC 发送方 和 接收方 都有的 key 进行计算,而没有这把 key 的第三方,则是 无法计算 出正确的 散列值的,这样就可以 防止数据被篡改。

AES、DES、3DES 都是 对称 的 块加密算法,加解密 的过程是 可逆的。常用的有 AES128、AES192、AES256 (默认安装的 JDK 尚不支持 AES256,需要安装对应的 jce 补丁进行升级 jce1.7,jce1.8)。

RSA 加密算法是目前最有影响力的 公钥加密算法,并且被普遍认为是目前 最优秀的公钥方案 之一。RSA 是第一个能同时用于 加密 和 数字签名 的算法,它能够 抵抗 到目前为止已知的 所有密码攻击,已被 ISO 推荐为公钥数据加密标准。

RSA加密算法 基于一个十分简单的数论事实:将两个大 素数 相乘十分容易,但想要对其乘积进行 因式分解 却极其困难,因此可以将 乘积 公开作为 加密密钥。

ECC 也是一种 非对称加密算法,主要优势是在某些情况下,它比其他的方法使用 更小的密钥,比如 RSA 加密算法,提供 相当的或更高等级 的安全级别。不过一个缺点是 加密和解密操作 的实现比其他机制 时间长 (相比 RSA 算法,该算法对 CPU 消耗严重)。

5.登录密码加密

Hash 特点: 1.算法是公开的 2.对相同数据运算,得到的结果是一样的 3.对不同数据运算,如 MD5 得到的结果默认是 128 位,32 个字符(16 进制标识)。 4.没法逆运算 5.信息摘要,信息“指纹”,是用来做数据识别的。

hash 加密: 1.md5. 2.sha1 2.sha256 3.sha516

用户密码加密 1.首先密码加密不能用 rsa 加密,因为 rsa 加密虽然在传输过程中是相对安全的,但是一旦开发人员变动带走了私钥与密钥,是很容易的获取用户的登录密码

2.hash 加密,hash 加密是不可逆的,加密后传输至服务端后,开发人员是获取不出用户的登录密码的,只需要将加密的 hash 值存入数据库中,但是这个方法现在也是不安全的。https://www.cmd5.com,这个网址可以查出大部分的密码

3.hash 加盐:所谓的 hash 加盐就是在原密码的基础上,添加上一段随机字符串(该字符串是由客户端开发人员写死的),然后进行 hash 加密,但是这种方法对于开发者的依赖比较大还有就是灵活性不高,当用户量大了后,如果想更换盐成本会很大

4.hamc 加密:也可以说是动态加盐(一个用户一个盐),当用户注册的时候,服务端会返回给客户端一个盐,然后进行两次 hash 加密,传输给服务端。这样不会对开发人员产生依赖,且由于是一个用户一个盐,这样更换起来也会比较方便

6.前后端鉴权

傻傻分不清之 Cookie、Session、Token、JWT

Token

token 即使是在计算机领域中也有不同的定义,这里我们说的 token,是指访问资源的凭据。例如当你调用 Google API,需要带上有效 token 来表明你请求的合法性。这个 token 是 Google 给你的,这代表 Google 给你的授权使得你有能力访问 API 背后的资源。

请求 API 时携带 token 的方式也有很多种,通过 HTTP Header 或者 url 参数 或者 google 提供的类库都可以:

// HTTP Header:

GET /drive/v2/files HTTP/1.1

Authorization: Bearer <token>

Host: www.googleapis.com/

// URL query string parameter

GET https://www.googleapis.com/drive/v2/files?token=<token>

// Python:

from googleapiclient.discovery import build

drive = build('drive', 'v2', credentials=credentials)

更具体的说,上面用于调用 API 的 token 我们称为细分为 access token。通常 access token 是有有效期限的,如果过期就需要重新获取。那么如何重新获取?现在我们要让时光倒流一会,回顾第一次获取 token 的流程是怎样的:

- 首先你需要向 Google API 注册你的应用程序,注册完毕之后你会拿到认证信息(credentials)包括 ID 和 secret。不是所有的程序类型都有 secret。

- 接下来就要向 Google 请求 access token。这里我们先忽略一些细节,例如请求参数(当然需要上面申请到的 secret)以及不同类型的程序的请求方式等。重要的是,如果你想访问的是用户资源,这里就会提醒用户进行授权。

- 如果用户授权完毕。Google 就会返回 access token。又或者是返回授权代码(authorization code),你再通过代码取得 access token

- token 获取到之后,就能够带上 token 访问 API 了

注意在第三步通过 code 兑换 access token 的过程中,Google 并不会仅仅返回 access token,还会返回额外的信息,这其中和之后更新相关的就是 refresh token

一旦 access token 过期,你就可以通过 refresh token 再次请求 access token。

以上只是大致的流程,并且故意省略了一些额外的概念。比如更新 access token 当然也可以不需要 refresh token,这要根据你的请求方式和访问的资源类型而定。

单点登录 SSO (Single sign-on)

通常公司内部会有非常多的工具平台供大家使用,比如人力资源,代码管理,日志监控,预算申请等等。如果每一个平台都实现自己的用户体系的话无疑是巨大的浪费,所以公司内部会有一套公用的用户体系,用户只要登陆之后,就能够访问所有的系统。这就是单点登录(SSO: Single Sign-On)

实例

最初的时候,服务的提供者只做了一个单系统,所有的功能都在单系统上,此时不需要SSO,一次登录就可以访问所有功能,后来用户量越来越大且功能服务越来越多,为了合理利用资源和降低耦合性,服务商将功能划分为多个子系统,而子系统的用户登录凭证是相互隔离的,如果在这个子系统登录完成,再访问另一个子系统还需要登录,这显然不太合适,而SSO就是对于这种问题的解决方案,在多个系统中,用户只需要某一个系统中登录,在其他系统中都无需再次验证用户身份即可静默登录,例如在百度一次登录,再访问贴吧、网盘等都可以静默登录。

OAUTH 与 SSO 区别

- 从信任角度来看,

OAUTH开放授权的服务端和第三方客户端不属于一个互相信任的应用群,而单点登录的子系统都在一个互相信任的应用群,通常是同一个公司提供的服务。 - 从资源角度来看,

OAUTH开放授权主要是让用户自行决定在服务端的个人资源是否允许第三方应用访问,而单点登录的资源本身都在子系统这边,主要服务是用于登录,以及管理用户在各个子系统的权限信息。

实现方案

共享 SESSION

如果系统是使用SESSION来记录用户信息的话,那么就可以采用共享SESSION的方式进行实现单点登录,使用SESSION信息作为单点登录的方式就需要解决两个问题,一是子系统的SESSION是相互隔离的问题,二是用户的SESSIONID如何在客户端共享的问题。

SESSION的一致性的解决方案主要有SESSION同步、SESSION集中存储的方式,SESSION同步比较消耗资源,所以一般还是使用SESSION集中存储的方式。

对于SESSIONID在客户端共享的问题,SESSIONID主要还是存储在COOKIE中,所以需要解决的问题是COOKIE的跨域问题,对于同一个顶级域名下的二级域名,可以通过在SET-COOKIE时设置domain属性为顶级域名,即可实现在顶级域名与二级域名三级域名下的COOKIE共享,若是需要非子域名下的COOKIE共享,可以考虑使用P3P隐私参考项目平台Platform for Privacy Preferences的header的方式跨域SET-COOKIE。

Ticket

Ticket方式也称为SSO-Token,其是一个用户身份的标识,这个标识在所有子系统群中是唯一的,并且所有的子系统SERVER都可以验证这个Token并同时能够拿到这个Token所代表的用户信息,同样这种方式也需要解决COOKIE的跨域问题,同样一般也是需要使用顶级域名的domain属性或者P3P的header的跨域SET-COOKIE。

CAS

CAS中央认证服务Central Authentication Service,将认证服务单独抽出作为一个子系统,所有的登录认证服务都在CAS认证中心进行。CAS系统像是一个中转中心,可以认证所有用户的身份,同样也可以直接通过在CAS系统登录后以登录态跳转到其他各个系统。

假如我们存在三个子系统,A系统A.com、B系统B.com、认证服务SSO.com,当用户已经注册,登录时的主要流程:

- 用户打开系统

A,此时用户未登录,系统自动跳转到认证服务系统SSO.com并携带参数存储跳转地址A.com。 - 用户在

SSO.com输入账号密码,点击登录验证成功后,中央认证服务器返回一个Ticket,并将已经登录的COOKIE写入SSO.com认证服务的域名下,SSO.com认证服务重定向至跳转到认证服务时携带的地址,也就是上一步的A.com,并携带中央认证服务端下发的Ticket。 - 系统

A得到Ticket并向本系统的服务器传递Ticket,服务端验证Ticket无误后获取Ticket中携带的用户信息,并设置当前A系统的此用户为登录态,下发COOKIE信息等用户凭据,至此该用户可正常使用A系统的服务。 - 此时用户打开

B系统,由于用户未在B系统登录,系统自动跳转到认证服务系统SSO.com并携带参数存储跳转地址B.com。 - 用户在

SSO.com已经处于登录状态,此时直接从中央认证服务器获取Ticket,然后重定向至跳转到认证服务时携带的地址,也就是上一步的B.com,并携带中央认证服务端下发的Ticket。 - 系统

B得到Ticket并向本系统的服务器传递Ticket,服务端验证Ticket无误后获取Ticket中携带的用户信息,并设置当前B系统的此用户为登录态,下发COOKIE信息等用户凭据,至此该用户可正常使用B系统的服务。

OAuth 2.0

OAuth2.0 原理图解:第三方网站为什么可以使用微信登录

- 用户通过客户端(可以是浏览器也可以是手机应用)想要访问 SP 上的资源,但是 SP 告诉用户需要进行认证,将用户重定向至 IdP

- IdP 向用户询问 SP 是否可以访问用户信息,如果用户同意,IdP 向客户端返回 access code

- 客户端拿 code 向 IdP 换 access token,并拿着 access token 向 SP 请求资源

- SP 接受到请求之后拿着附带 token 向 IdP 验证用户的身份

用户从 IdP 返回客户端的方式是通过 URL 重定向,这里的 URL 允许自定义 schema,所以即使在手机上也能拉起应用;另一方面因为 IdP 向客户端传递的是 code,而不是 XML 信息,所以 code 可以很轻易的附着在重定向 URL 上进行传递

但以上的 SSO 流程体现不出 OAuth 的本意。OAuth 的本意是一个应用允许另一个应用在用户授权的情况下访问自己的数据,OAuth 的设计本意更倾向于授权而非认证(当然授权用户信息就间接实现了认证), 虽然 Google 的 OAuth 2.0 API 同时支持授权和认证。所以你在使用 Facebook 或者 Gmail 账号登陆第三方站点时,会出授权对话框告诉你第三方站点可以访问你的哪些信息,需要征得你的同意:

Refresh Token

为什么我们需要 refresh token?

这样的处理是为了职责的分离:refresh token 负责身份认证,access token 负责请求资源。虽然 refresh token 和 access token 都由 IdP 发出,但是 access token 还要和 SP 进行数据交换,如果公用的话这样就会有身份泄露的可能。并且 IdP 和 SP 可能是完全不同的服务提供的。而在第一小节中我们之所以没有这样的顾虑是因为 IdP 和 SP 都是 Google

7.分布式 SESSION 一致性

SESSION是服务器为客户端创建的一个会话,存储用户的相关信息,用以标识用户身份等。在单服务器环境下是不需要考虑会话的一致性的问题的,但是在集群环境下就会出现一些问题,假如一个用户在登录请求时负载均衡到了A服务器,A服务器为其分配了SESSION,下次请求数据时被分配到了B服务器,此时由于B服务器不存在此用户的SESSION,此用户会被重定向到登录页面,这种情况是不合理的业务逻辑,所以需要维护SESSION的一致性。

解决方案

[SESSION]同步

多个服务器之间互相同步SESSION,即A服务器生成一个SESSION信息后同步传输到B、C、D等服务器,同样B、C、D服务器生成SESSION信息后也需要同步到A,这样每个服务器之间都包含全部的SESSION

优点

- 大部分应用服务器都提供了

SESSION复制的功能来实现集群

缺点

SESSION需要网络传输进行同步,其会占用带宽,并且存在一定的延迟- 一旦某台机器的

SESSION信息有所变化,必须同步更新所有服务器SESSION内容 - 每个服务器都会存储全部的用户信息,性能随着服务器增加急剧下降,而且容易引起广播风暴

SESSION 映射

通过将负载均衡服务器进行修改,通过对返回给用户的SESSION ID或者用户请求的IP地址进行标记,也就是使用第四层传输层中读取网络层的IP或者是在第七层中读取HTTP协议中某些属性来做HASH,保证对于此用户的请求全部落到同一台服务器上

优点

- 实现相对简单

- 只要分配服务器时均匀,则多台服务器是负载均衡的

缺点

- 一旦某台服务器宕机,则会影响落在此服务器请求上的全部用户

- 负载均衡服务器变为了一个有状态的节点,内存消耗会更大,容灾更麻烦

客户端存储

将数据直接存储到客户端比如Cookie或请求头中,每次请求客户端自动携带数据信息

优点

- 简单,高效

- 服务端不需要储存标记用户信息

缺点

- 安全性较差,对于敏感信息必须加密

- 每次请求可能携带大量数据,占用外网带宽

- 数据存储在客户端就会存在泄密、篡改、窃取等隐患

后端集中存储

将SESSION存储在一台单独的服务器中的数据库中,例如Mysql、Oracle、SqlServer、Redis、Mongodb等等,各SERVER服务器需要用户信息时携带SESSION ID对于集中存储服务器进行请求,进而获取用户信息

优点

- 没有安全隐患

- 可以方便的水平拓展

SERVER服务器重启不会造成SESSION丢失

缺点

- 每次请求都增加了一次对于存储服务器的网络请求

- 会对集中存储服务器存在大量请求,数据库压力比较大

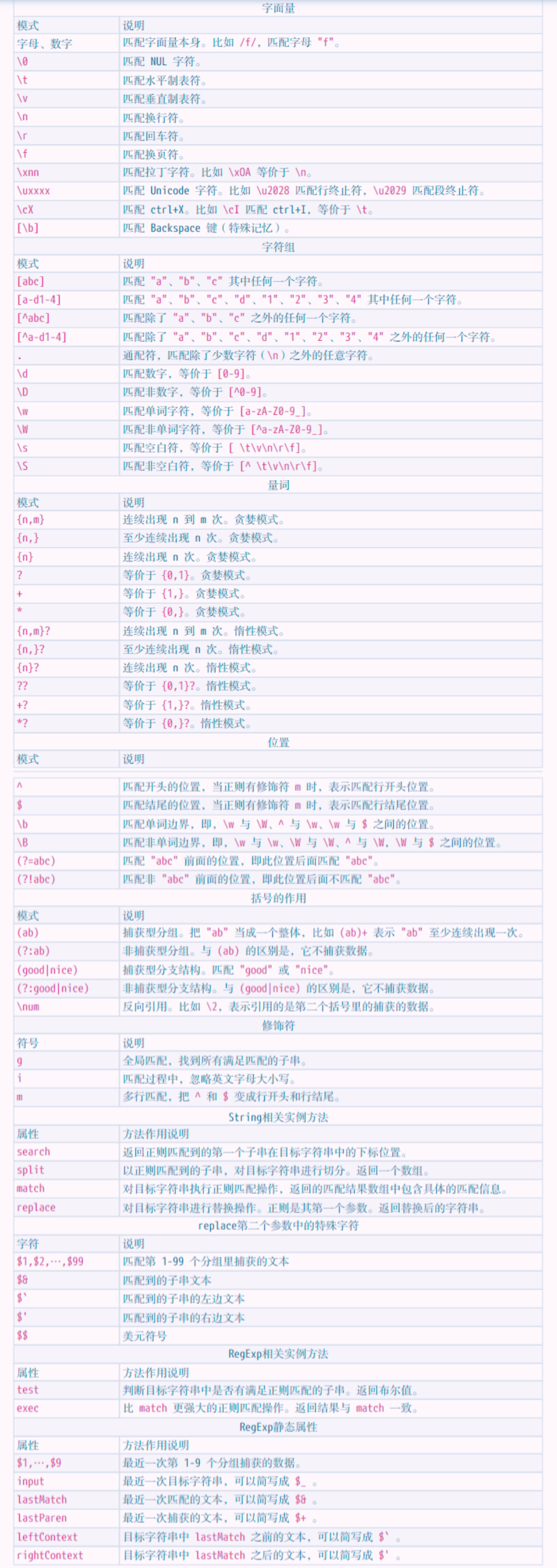

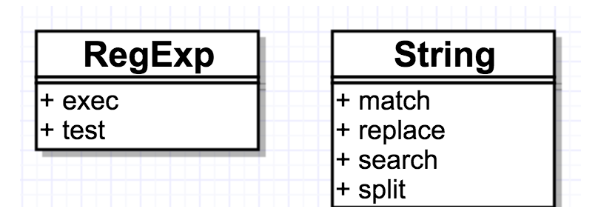

正则表达式

限定符

? 指前面的一个字符出现 0 次或者 1 次 可有可无

* 指前面的一个字符出现 0 次或者多次

+ 指前面的一个字符出现至少 1 次 就相当于正区间

{} 指前面的一个字符出现次数范围 {2,6} 2-6 次 {2,} 至少 2 次

{ab}+ 这样匹配了 ab 多次

或运算符

a (cat|dog) 可以匹配 a cat 或者 a dog

字符类

[abc]+ 匹配有abc的字符

[a-z] [A-Z] [0-9] [a-zA-Z] [a-zA-Z0-9]

^ [^0-9]+ 不含数字的字符

元字符

\d 数字字符

\D 非数字字符

\w 单词字符(英文,数字以及下划线)

\W 非单词字符

\s 空白字符(包含 Tab,制表符以及换行符)

\S 非空白字符

. 任意字符 不包含换行符

^ 只匹配行首

$ 只匹配行尾

贪婪与懒惰匹配

* + {} 会尽可能多的去匹配字符

比如匹配 html 标签 <.+?> ?将贪婪模式设置为懒惰模式

\b 和 \B

\b 是单词边界,具体就是 \w 与 \W 之间的位置,也包括 \w 与 ^ 之间的位置,和 \w 与 $ 之间的位置

(?=p) 和 (?!p)

分组

/a+/ 匹配连续出现的 "a",而要匹配连续出现的 "ab" 时,需要使用 /(ab)+/。 其中括号是提供分组功能,使量词 + 作用于 "ab" 这个整体,测试如下:

var regex = /(ab)+/g;

var string = "ababa abbb ababab";

console.log(string.match(regex));

// => ["abab", "ab", "ababab"]

分组引用是括号一个重要的作用,有了它,我们就可以进行数据提取,以及更强大的替换操作

假设格式是 yyyy-mm-dd 的,我们可以先写一个简单的正则:

var regex = /\d{4}-\d{2}-\d{2}/;

然后再修改成括号版的:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

正则引擎在匹配过程中,给每一个分组都开辟一个空间,用来存储每一个分组匹配到的数据

比如提取出年、月、日,可以这么做:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

console.log(string.match(regex));

// => ["2017-06-12", "2017", "06", "12", index: 0, input: "2017-06-12"]

match 返回的一个数组,第一个元素是整体匹配结果,然后是各个分组(括号里)匹配的内容,然后是匹配下标,最后是输入的文本

也可以使用正则实例对象的 exec 方法:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

console.log(regex.exec(string));

// => ["2017-06-12", "2017", "06", "12", index: 0, input: "2017-06-12"]

也可以使用构造函数的全局属性 $1 至 $9 来获取:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

regex.test(string); // 正则操作即可,例如

//regex.exec(string);

//string.match(regex);

console.log(RegExp.$1); // "2017"

console.log(RegExp.$2); // "06"

console.log(RegExp.$3); // "12"

想把 yyyy-mm-dd 格式,替换成 mm/dd/yyyy 怎么做?

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

var result = string.replace(regex, "$2/$3/$1");

console.log(result);

// => "06/12/2017"

其中 replace 中的,第二个参数里用 $1、$2、$3 指代相应的分组。等价于如下的形式:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

var result = string.replace(regex, function () {

return RegExp.$2 + "/" + RegExp.$3 + "/" + RegExp.$1;

});

console.log(result);

// => "06/12/2017"

也等价于:

var regex = /(\d{4})-(\d{2})-(\d{2})/;

var string = "2017-06-12";

var result = string.replace(regex, function (match, year, month, day) {

return month + "/" + day + "/" + year;

});

console.log(result);

// => "06/12/2017"

实例

RGB 颜色值匹配

#[a-fA-F0-9]{6}\b \b 设置单词字符的边界

16 进制颜色

/#([0-9a-fA-F]{6}|[0-9a-fA-F]{3})/g

时间匹配

时刻匹配

/^[01][0-9]|[2][0-3]):[0-5][0-9]$/

如果省略 0

/^(0?[0-9]|1[0-9]|[2][0-3]):(0?[0-9]|[1-5][0-9])$/

日期匹配

/^[0-9]{4}-(0[1-9]|1[0-2])-(0[1-9]|[12][0-9]|3[01]$/g

IPv4 匹配

\d+.\d+.\d+.\d+

js 用法

var re = /ab+c/

var re = new RegExp('ab+c')

regex.test(str)

是否匹配

var str = "hello world!";

var result = /^hello/.test(str); // true

regex.exec(str)

得到匹配后的数组

var myRe = /d(b+)d/g;

myRe.exec("cdbbdbsdbdbz"); // ["dbbd", "bb", index: 1, input: "cdbbdbsdbdbz"]

myRe.exec("cdbbdbsdbdbz"); // ["dbd", "b", index: 7, input: "cdbbdbsdbdbz"]

myRe.exec("cdbbdbsdbdbz"); // null

str.match(regex)

如果是 global 匹配则出所有匹配的数组,如果不是,则出第一个匹配的字符串,以及相应的捕获内容

"cdbbdbsdbdbz".match(/d(b+)d/g); // ["dbbd", "dbd"]

"cdbbdbsdbdbz".match(/d(b+)d/); // ["dbbd", "bb", index: 1, input: "cdbbdbsdbdbz"]

str.search(regex)

得到第一次匹配的位置

"cdbbdbsdbdbz".search(/d(b+)d/); // 1

"xxx".search(/d(b+)d/); // -1 没有匹配

str.split(regex)

按照匹配拆分字符串

var names = "Harry Trump ;Fred Barney; Helen Rigby ; Bill Abel ;Chris Hand ";

var re = /\s*;\s*/;

var nameList = names.split(re);

// [ "Harry Trump", "Fred Barney", "Helen Rigby", "Bill Abel", "Chris Hand " ]

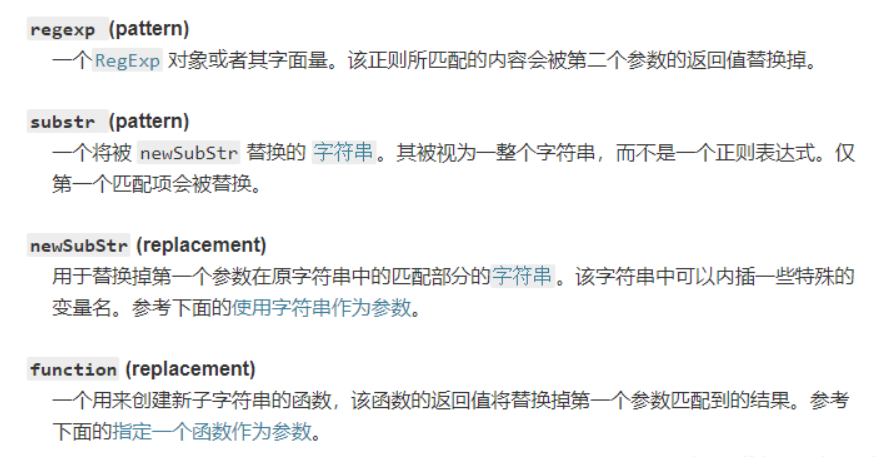

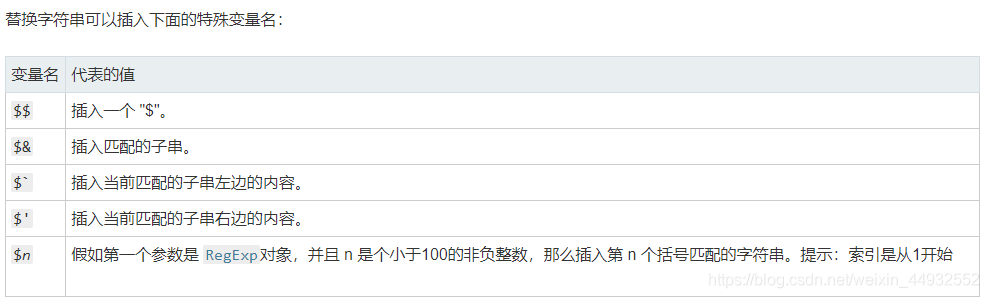

str.replace(regex)

按照匹配覆盖字符串

var re = /apples/gi;

var str = "Apples are round, and apples are juicy.";

var newstr = str.replace(re, "oranges");

// // oranges are round, and oranges are juicy.

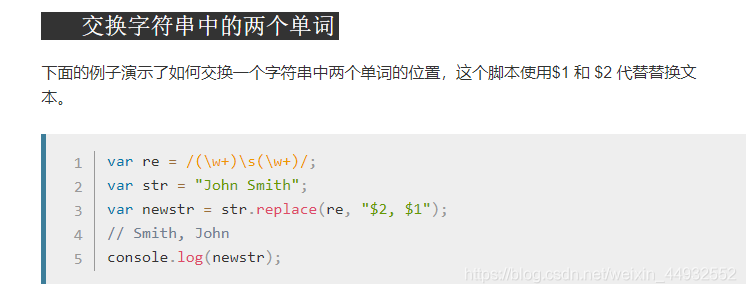

如果第二个参数是字符串,可以使用特殊的字符序列,将正则表达式操作得到的值插入到结果字符串中

$n:匹配第 n 个捕获组的子字符串。

返回值:

一个部分或全部匹配由替代模式所取代的新的字符串。

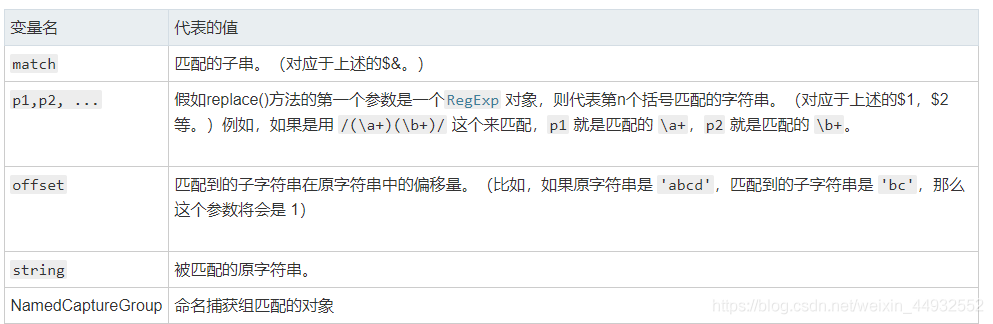

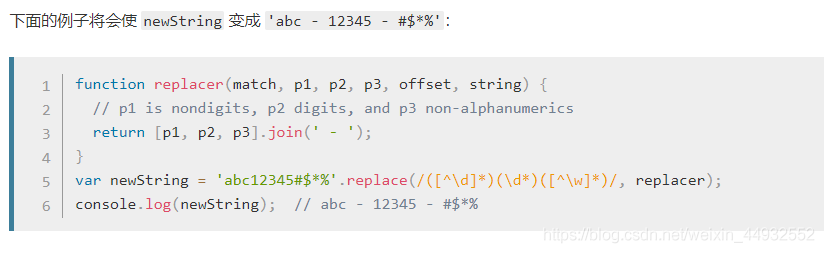

补充理解的知识点: 1.如果第一个参数是字符串,那么只会替换第一个子字符串。要想替换所有子字符串,唯一的方法就是提供一个正则表达式,指定全局匹配 g 模式。 2.该方法并不改变调用它的字符串本身,而只是返回一个新的替换后的字符串。 3.可以指定一个函数作为第二个参数。在这种情况下,当匹配执行后,该函数就会执行。 函数的返回值作为替换字符串。 (注意:上面提到的特殊替换参数在这里不能被使用。) 另外要注意的是,如果第一个参数是正则表达式,并且其为全局匹配模式,那么这个方法将被多次调用,每次匹配都会被调用。

面向对象理论

1.为什么选择面向对象编程

① 易扩展:由于面向对象编程封装、继承、多态的三大特性,使得设计出来的系统高内聚、低耦合,整个系统灵活、易扩展,而且成本较低。 ② 程序的鲁棒性好:开发过程中可以重用已有的并在相关领域经过长期测试的代码,这对系统的鲁棒性有良好的促进作用。 ③ 效率高:在软件开发时,根据需要将现实世界的事物抽象成类,类的属性表示事物的特有性质、类的方法表示事物的行为。一个类对象表示一个事物的实例。这种方式更贴近人类的日常思维,能够提高程序的开发效率和质量。

2.面向对象的特性

(1)封装

即隐藏对象的属性和实现细节,仅对外公开接口。 封装的优点如下: ① 防止使用者有意无意地篡改重要的系统属性 ② 提高了各个子系统之间的松耦合性,提高系统的独立性。当一个系统内部发生改动时,只要对外提供的接口不变,就不会影响到其他的系统。 ③ 提高软件的可重用性。每个系统都是一个相对独立的整体,可以在多种环境中得到重用。 ④ 降低了建构大型系统的风险。即使整个系统不成功,个别独立的子系统依然是有价值的。

(2)继承

子类可以继承父类的属性和方法。同时,子类中还可以扩展出新的属性和方法。 继承的优点如下: 提高了系统的可重用性和可扩展性。

(3)多态

多态指当系统 A 访问系统 B 的服务时,系统 B 可以通过多种实现方式来提供服务。主要包括:重载(overload)和重写(override)两种方式。 重载必须满足以下条件: ① 方法名相同 ② 参数的个数、顺序、类型至少有 1 项不同 ③ 返回类型可以不同(两个方法不能仅有返回类型不同!!!) ④ 修饰符可以不同

重写发生在父类与子类之间,必须满足以下条件: ① 方法名、参数、返回值一定要相同 ② 子类方法不能缩小父类方法的访问权限 ③ 子类方法不能比父类抛出更多的异常 ④ 父类的非静态方法不能被子类覆盖为静态方法 ⑤ 父类的静态方法不能被子类覆盖为非静态的方法 ⑥ 子类可以定义与父类静态方法同名的静态方法 ⑦ 子类不能覆盖父类的私有方法

注:重载与重写的区别: ① 重载要求两个函数的函数名相同,但参数的个数、种类或者类型不同、返回类型不同(可以仅仅参数不同,不能仅仅只有返回类型不同);重写要求两个函数的返回值类型、函数名、参数完全相同

3.面向对象编程的原则

(1)单一职责原则:设计一个类时要考虑好类的属性和方法。不要有多余的方法,否则会出现权责不明,对程序的开发和维护都十分不利。 (2)开放封闭原则:对类的扩展是开放的(可以创建子类继承父类或者抽象方法、也可以创建类来实现接口,这样可以提高代码的可重用性),对类的更改是封闭的(尽量减少对已有类的更改,否则可能会引发一系列错误)。 (3)依赖倒置原则:在 MVC 设计模式中,Control 层依赖于 Service 层,Service 层依赖于 Dao 层,这叫依赖实现编程,这种方式有一个缺点就是各层之间的耦合性太强; 现将 MVC 各层抽象,在 Control 层和 Service 层之间建立关系,在 Service 和 Dao 层之间建立关系,这叫依赖抽象编程,这种方式降低了各层之间的耦合性,提高了独立性。 从“依赖实现编程”到“依赖抽象编程”的转变,即是依赖倒置原则 (4)里氏代换原则:子类必须能够替换掉他们的父类 (5)迪米特原则:两个没有直接联系的类之间要发生相互作用,可以通过第三个类来实现。 (6)组合原则:尽量少用类之间的继承,尽量使用组合。过多的继承会是整个系统变得复杂。而组合是一种用多个简单子系统组装出复杂系统的有效手段。

操作系统原理

1.进程和线程

进程(Process)是系统进行资源分配和调度的基本单位。

进程也是抢占处理机的调度单位,它拥有一个完整的虚拟地址空间。当进程发生调度时,不同的进程拥有不同的虚拟地址空间,而同一进程内的不同线程共享同一地址空间。

与进程相对应,线程与资源分配无关,它属于某一个进程,并与进程内的其他线程一起共享进程的资源。

线程只由相关堆栈(系统栈或用户栈)寄存器和线程控制表 TCB 组成。寄存器可被用来存储线程内的局部变量,但不能存储其他线程的相关变量。

调度与操作系统的线程的实现有关,如果是管态线程与目态线程是一一对应,则调度的最小单位可以是线程,但我觉得这也就是理论上,一般的商用操作系统可能操作系统调度的单位也是进程。

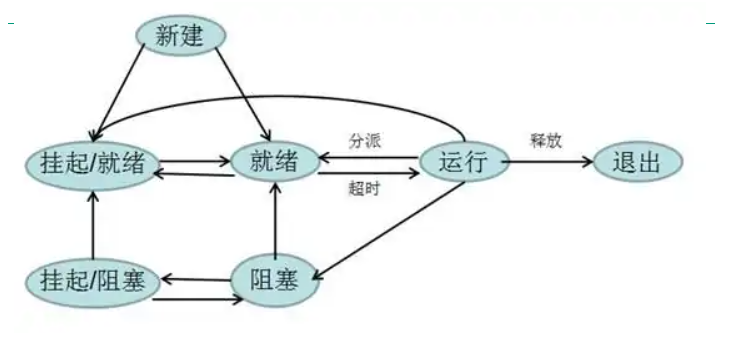

进程一般有三个状态:就绪状态、执行状态和等待状态【或称阻塞状态】;进程只能由父进程建立,系统中所有的进程形成一种进程树的层次体系;挂起命令可由进程自己和其他进程发出,但是解除挂起命令只能由其他进程发出。

进程控制块(PCB):PCB 不但可以记录进程的属性信息,以便操作系统对进程进行控制和管理,而且 PCB 标志着进程的存在,操作系统根据系统中是否有该进程的进程控制块 PCB 而知道该进程存在与否。

系统建立进程的同时就建立该进程的 PCB,在撤销一个进程时,也就撤销其 PCB,故进程的 PCB 对进程来说是它存在的具体的物理标志和体现。一般 PCB 包括以下三类信息:进程标识信息;处理器状态信息;进程控制信息。

2.进程间通信

前端领域已经不是单纯写在浏览器里跑的页面就可以了,还要会 electron、nodejs 等,而这俩技术都需要掌握进程通信。

nodejs 是 js 的一个运行时,和浏览器不同,它扩展了很多封装操作系统能力的 api,其中就包括进程、线程相关 api,而学习进程 api 就要学习进程之间的通信机制。

electron 是基于 chromium 和 nodejs 的桌面端开发方案,它的架构是一个主进程,多个渲染进程,这两种进程之间也需要通信,要学习 electron 的进程通信机制。

这篇文章我们就来深入了解一下进程通信。

本文会讲解以下知识点:

- 进程是什么

- 本地进程通信的四种方式

- ipc、lpc、rpc 都是什么

- electron 如何做进程通信

- nodejs 的 child_process 和 cluster 如何做进程通信

- 进程通信的本质

进程

我们写完的代码要在操作系统之上跑,操作系统为了更好的利用硬件资源,支持了多个程序的并发和硬件资源的分配,分配的单位就是进程,这个进程就是程序的执行过程。比如记录程序执行到哪一步了,申请了哪些硬件资源、占用了什么端口等。

进程包括要执行的代码、代码操作的数据,以及进程控制块 PCB(Processing Control Block),因为程序就是代码在数据集上的执行过程,而执行过程的状态和申请的资源需要记录在一个数据结构(PCB)里。所以进程由代码、数据、PCB 组成。

pcb 中记录着 pid、执行到的代码地址、进程的状态(阻塞、运行、就绪等)以及用于通信的信号量、管道、消息队列等数据结构。

进程从创建到代码不断的执行,到申请硬件资源(内存、硬盘文件、网络等),中间还可能会阻塞,最终执行完会销毁进程。这是一个进程的生命周期。

进程对申请来的资源是独占式的,每个进程都只能访问自己的资源,那进程之间怎么通信呢?

进程通信

不同进程之间因为可用的内存不同,所以要通过一个中间介质通信。

信号量

如果是简单的标记,通过一个数字来表示,放在 PCB 的一个属性里,这叫做信号量,比如锁的实现就可以通过信号量。

这种信号量的思想我们写前端代码也经常用,比如实现节流的时候,也要加一个标记变量。

管道

但是信号量不能传递具体的数据啊,传递具体数据还得用别的方式。比如我们可以通过读写文件的方式来通信,这就是管道,如果是在内存中的文件,叫做匿名管道,没有文件名,如果是真实的硬盘的文件,是有文件名的,叫做命名管道。

文件需要先打开,然后再读和写,之后再关闭,这也是管道的特点。管道是基于文件的思想封装的,之所以叫管道,是因为只能一个进程读、一个进程写,是单向的(半双工)。而且还需要目标进程同步的消费数据,不然就会阻塞住。

这种管道的方式实现起来很简单,就是一个文件读写,但是只能用在两个进程之间通信,只能同步的通信。其实管道的同步通信也挺常见的,就是 stream 的 pipe 方法。

消息队列

管道实现简单,但是同步的通信比较受限制,那如果想做成异步通信呢?加个队列做缓冲(buffer)不就行了,这就是消息队列。

消息队列也是两个进程之间的通信,但是不是基于文件那一套思路,虽然也是单向的,但是有了一定的异步性,可以放很多消息,之后一次性消费。

共享内存

管道、消息队列都是两个进程之间的,如果多个进程之间呢?

我们可以通过申请一段多进程都可以操作的内存,叫做共享内存,用这种方式来通信。各进程都可以向该内存读写数据,效率比较高。

共享内存虽然效率高、也能用于多个进程的通信,但也不全是好处,因为多个进程都可以读写,那么就很容易乱,要自己控制顺序,比如通过进程的信号量(标记变量)来控制。

共享内存适用于多个进程之间的通信,不需要通过中间介质,所以效率更高,但是使用起来也更复杂。

上面说的这些几乎就是本地进程通信的全部方式了,为什么要加个本地呢?

ipc、rpc、lpc

进程通信就是 ipc(Inter-Process Communication),两个进程可能是一台计算机的,也可能网络上的不同计算机的进程,所以进程通信方式分为两种:

本地过程调用 LPC(local procedure call)、远程过程调用 RPC(remote procedure call)。

本地过程调用就是我们上面说的信号量、管道、消息队列、共享内存的通信方式,但是如果是网络上的,那就要通过网络协议来通信了,这个其实我们用的比较多,比如 http、websocket。

所以,当有人提到 ipc 时就是在说进程通信,可以分为本地的和远程的两种来讨论。

远程的都是基于网络协议封装的,而本地的都是基于信号量、管道、消息队列、共享内存封装出来的,比如我们接下来要探讨的 electron 和 nodejs。

electron 进程通信

electron 会先启动主进程,然后通过 BrowserWindow 创建渲染进程,加载 html 页面实现渲染。这两个进程之间的通信是通过 electron 提供的 ipc 的 api。

ipcMain、ipcRenderer

主进程里面通过 ipcMain 的 on 方法监听事件

import { ipcMain } from "electron";

ipcMain.on("异步事件", (event, arg) => {

event.sender.send("异步事件返回", "yyy");

});

渲染进程里面通过 ipcRenderer 的 on 方法监听事件,通过 send 发送消息

import { ipcRenderer } from "electron";

ipcRender.on("异步事件返回", function (event, arg) {

const message = `异步消息: ${arg}`;

});

ipcRenderer.send("异步事件", "xxx");

api 使用比较简单,这是经过 c++ 层的封装,然后暴露给 js 的事件形式的 api。

我们可以想一下它是基于哪种机制实现的呢?

很明显有一定的异步性,而且是父子进程之间的通信,所以是消息队列的方式实现的。

remote

除了事件形式的 api 外,electron 还提供了远程方法调用 rmi (remote method invoke)形式的 api。

其实就是对消息的进一步封装,也就是根据传递的消息,调用不同的方法,形式上就像调用本进程的方法一样,但其实是发消息到另一个进程来做的,和 ipcMain、ipcRenderer 的形式本质上一样。

比如在渲染进程里面,通过 remote 来直接调用主进程才有的 BrowserWindow 的 api。

const { BrowserWindow } = require("electron").remote;

let win = new BrowserWindow({ width: 800, height: 600 });

win.loadURL("https://github.com");

小结一下,electron 的父子进程通信方式是基于消息队列封装的,封装形式有两种,一种是事件的方式,通过 ipcMain、ipcRenderer 的 api 使用,另一种则是进一步封装成了不同方法的调用(rmi),底层也是基于消息,执行远程方法但是看上去像执行本地方法一样。

nodejs

nodejs 提供了创建进程的 api,有两个模块: child_process 和 cluster。很明显,一个是用于父子进程的创建和通信,一个是用于多个进程。

child_process

child_process 提供了 spawn、exec、execFile、fork 的 api,分别用于不同的进程的创建:

spawn、exec

如果想通过 shell 执行命令,那就用 spawn 或者 exec。因为一般执行命令是需要返回值的,这俩 api 在返回值的方式上有所不同。

spawn 返回的是 stream,通过 data 事件来取,exec 进一步分装成了 buffer,使用起来简单一些,但是可能会超过 maxBuffer。

const { spawn } = require('child_process');

var app = spawn('node','main.js' {env:{}});

app.stderr.on('data',function(data) {

console.log('Error:',data);

});

app.stdout.on('data',function(data) {

console.log(data);

});

其实 exec 是基于 spwan 封装出来的,简单场景可以用,有的时候要设置下 maxBuffer。

const { exec } = require('child_process');

exec('find . -type f', { maxBuffer: 1024*1024 }(err, stdout, stderr) => {

if (err) {

console.error(`exec error: ${err}`); return;

}

console.log(stdout);

});

execFile

除了执行命令外,如果要执行可执行文件就用 execFile 的 api:

const { execFile } = require("child_process");

const child = execFile("node", ["--version"], (error, stdout, stderr) => {

if (error) {

throw error;

}

console.log(stdout);

});

fork

还有如果是想执行 js ,那就用 fork:

const { fork } = require("child_process");

const xxxProcess = fork("./xxx.js");

xxxProcess.send("111111");

xxxProcess.on("message", (sum) => {

res.end("22222");

});

小结

简单小结一下 child_process 的 4 个 api:

如果想执行 shell 命令,用 spawn 和 exec,spawn 返回一个 stream,而 exec 进一步封装成了 buffer。除了 exec 有的时候需要设置下 maxBuffer,其他没区别。

如果想执行可执行文件,用 execFile。

如果想执行 js 文件,用 fork。

child_process 的进程通信

说完了 api 我们来说下 child_process 创建的子进程怎么和父进程通信,也就是怎么做 ipc。

pipe

首先,支持了 pipe,很明显是通过管道的机制封装出来的,能同步的传输流的数据。

const { spawn } = require("child_process");

const find = spawn("cat", ["./aaa.js"]);

const wc = spawn("wc", ["-l"]);

find.stdout.pipe(wc.stdin);

比如上面通过管道把一个进程的输出流传输到了另一个进程的输入流,和下面的 shell 命令效果一样:

cat ./aaa.js | wc -l

message

spawn 支持 stdio 参数,可以设置和父进程的 stdin、stdout、stderr 的关系,比如指定 pipe 或者 null。还有第四个参数,可以设置 ipc,这时候就是通过事件的方式传递消息了,很明显,是基于消息队列实现的。

const { spawn } = require("child_process");

const child = spawn("node", ["./child.js"], {

stdio: ["pipe", "pipe", "pipe", "ipc"],

});

child.on("message", (m) => {

console.log(m);

});

child.send("xxxx");

而 fork 的 api 创建的子进程自带了 ipc 的传递消息机制,可以直接用。

const { fork } = require("child_process");

const xxxProcess = fork("./xxx.js");

xxxProcess.send("111111");

xxxProcess.on("message", (sum) => {

res.end("22222");

});

cluster

cluster 不再是父子进程了,而是更多进程,也提供了 fork 的 api。

比如 http server 会根据 cpu 数启动多个进程来处理请求。

import cluster from "cluster";

import http from "http";

import { cpus } from "os";

import process from "process";

const numCPUs = cpus().length;

if (cluster.isPrimary) {

for (let i = 0; i < numCPUs; i++) {

cluster.fork();

}

} else {

const server = http.createServer((req, res) => {

res.writeHead(200);

res.end("hello world\n");

});

server.listen(8000);

process.on("message", (msg) => {

if (msg === "shutdown") {

server.close();

}

});

}

它同样支持了事件形式的 api,用于多个进程之间的消息传递,因为多个进程其实也只是多个父子进程的通信,子进程之间不能直接通信,所以还是基于消息队列实现的。

共享内存

子进程之间通信还得通过父进程中转一次,要多次读写消息队列,效率太低了,就不能直接共享内存么?

现在 nodejs 还是不支持的,可以通过第三方的包 shm-typed-array 来实现,感兴趣可以看一下。

总结

进程包括代码、数据和 PCB,是程序的一次执行的过程,PCB 记录着各种执行过程中的信息,比如分配的资源、执行到的地址、用于通信的数据结构等。

进程之间需要通信,可以通过信号量、管道、消息队列、共享内存的方式。

- 信号量就是一个简单的数字的标记,不能传递具体数据。

- 管道是基于文件的思想,一个进程写另一个进程读,是同步的,适用于两个进程。

- 消息队列有一定的 buffer,可以异步处理消息,适用于两个进程。

- 共享内存是多个进程直接操作同一段内存,适用于多个进程,但是需要控制访问顺序。

这四种是本地进程的通信方式,而网络进程则基于网络协议的方式也可以做进程通信。

进程通信叫做 ipc,本地的叫做 lpc,远程的叫 rpc。

其中,如果把消息再封装一层成具体的方法调用,叫做 rmi,效果就像在本进程执行执行另一个进程的方法一样。

electron 和 nodejs 都是基于上面的操作系统机制的封装:

- elctron 支持 ipcMain 和 ipcRenderer 的消息传递的方式,还支持了 remote 的 rmi 的方式。

- nodejs 有 child_process 和 cluster 两个模块和进程有关,child_process 是父子进程之间,cluster 是多个进程:

- child_process 提供了用于执行 shell 命令的 spawn、exec,用于执行可执行文件的 execFile,用于执行 js 的 fork。提供了 pipe 和 message 两种 ipc 方式。

- cluster 也提供了 fork,提供了 message 的方式的通信。

当然,不管封装形式是什么,都离不开操作系统提供的信号量、管道、消息队列、共享内存这四种机制。

ipc 是开发中频繁遇到的需求,希望这篇文章能够帮大家梳理清楚从操作系统层到不同语言和运行时的封装层次的脉络。

3.死锁产生原因和解决

死锁:两个或多个并发进程中,如果每个进程持有某种资源而又都等待着别的进程释放它或它们现在保持着的资源,否则就不能向前推进。此时称这一组进程为死锁

引起死锁的原因和必要条件 引起死锁的原因: ① 系统资源不足 ② 进程推进顺序非法

产生死锁的必要条件 ① 互斥条件——涉及的资源是非共享的,即为临界资源 ② 不剥夺条件——进程所获得的资源在未使用完毕之前,不能被其它进程强行夺走 ③ 部分分配——进程每次申请它所需要的一部分资源。在等待新资源的同时,进程继续占用已分配到的资源 ④ 环路条件——存在一种进程的循环链,链中的每一个进程已获得的资源同时被链中下一个进程所请求

为了使系统不发生死锁,必须要破坏产生死锁的四个必要条件之一

① 采用资源静态分配方法预防死锁 ② 采用资源动态分配、有控分配方法来避免死锁 ③ 当死锁发生时检测出死锁,并设法修复 ④ 忽略死锁,一旦发生死锁便重启系统(这种方法被绝大多数操作系统所采用)

死锁的动态避免就是采用资源动态分配的方式 ① 有序资源分配方法:系统中所有资源都给一个唯一的编号,所有分配请求必须以上升的次序进行,当遵守上升次序的规则时,若资源可用,则予以分配;否则,请求者等待。 ② 银行家算法:申请者事先说明对各类资源的最大需求量。在进程活动期间动态申请某类资源时,由系统审查现有该类资源的数目是否能满足当前进程的最大需求量,如能满足就予以分配,否则拒绝。

4.操作系统资源分配

资源管理目的:为用户提供一种简单而有效地使用资源的方法 任务:1、资源数据结构的描述 2、确定资源的分配原则和调度原则 3、执行资源分配 4、存取控制和安全保护

操作系统对资源区分两种不同的概念 ① 物理资源——系统中那些物理、可实际使用的资源 ② 虚拟资源——逻辑资源。是经过操作系统改造的、用户看到的,使用方便的虚资源

目的:① 方便用户使用 ② 资源可动态分配,提高资源利用率

资源分配机制 资源描述器:描述各类资源的最小分配单位的数据结构 资源信息块:描述某类资源的请求者、可利用的资源以及该类资源分配程序的地址

资源分配策略:在众多个请求者中选一个满足条件的请求者原则

资源分配策略具体如何体现? 体现在资源请求队列的排序原则上 (1)先请求先服务策略(FIFO) ① 排序原则——按请求的先后次序排序:每一个新产生的请求均排在资源请求队列的队尾。 ② 资源可用时的处理:资源可用时,取资源请求队列队首元素,将该资源分配给请求者。

(2)优先调度策略 ① 排序原则——按请求的优先级高低排序 对每一个进程制定一个优先级 按优先级的高低排序——每一个新产生的请求按对应进程的优先级高低插入到队列的相应位置。 (3)针对设备特性的调度策略 调度目标:当有大量的 I/O 请求时,降低完成这些 I/O 服务的总时间 移臂调度:最短寻道时间优先算法(SSTF)、扫描算法(SCAN) 旋转调度

如何确定移动臂磁盘组中磁盘块的物理位置

计算机组成原理

1.怎么存储数

- 在 JS 中能否表示的数字的绝对值范围是 5e-324 ~ 1.7976931348623157e+308,这一点可以通过

Number.MAX_VALUE和Number.MIN_VALUE来得到证实 - 在 JS 中能够表示的最大安全整数的范围是:-9007199254740991 ~ 9007199254740991,这一点可以通过

Number.MIN_SAFE_INTEGER和Number.MAX_SAFE_INTEGER来求证

存在的问题

在四则运算中存在精度丢失的问题,比如:

01 + 0.2 //0.30000000000000004超过最大安全整数的运算是不安全的,比如:

9007199254740991 + 2 // 9007199254740992把这个浮点数转成对应的二进制数,并用科学计数法表示

把这个数值通过IEEE 754标准表示成真正会在计算机中存储的值

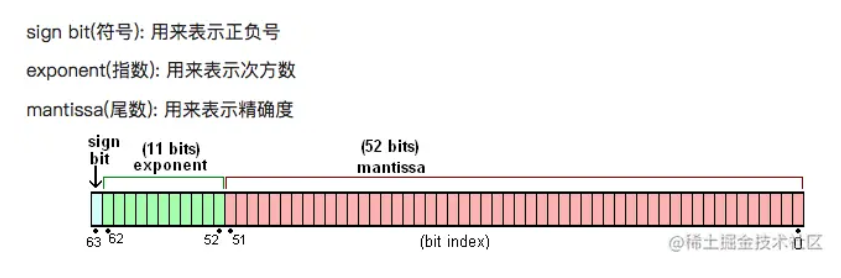

我们知道,JS 中的 Number 类型使用的是双精度浮点型,也就是其他语言中的 double 类型。而双精度浮点数使用 64 bit 来进行存储,结构图如下:

也就是说一个 Number 类型的数字在内存中会被表示成:s x m x 2^e这样的格式。

在ES 规范中规定 e 的范围在-1074 ~ 971,而 m 最大能表示的最大数是 52 个 1,最小能表示的是 1,这里需要注意:

2.什么是补码

原码

一个 8 位的存储单元可以存储 00000000 ~ 11111111 共 256 种数字,真值(即真实数值,用 10 进制表示)从 0 ~ 255。为了引入负数,所以设计出了原码:用存储单元的第一位表示符号,1 位负,0 为正,后面的位表示真值的绝对值。同样以 8 位存储单元位例,在用原码的方式下我们依然可以表示 256 个数,从 11111111 ~ 01111111,真值范围为 -127 ~ 127,可能你发现真值一共只有255 个,因为 10000000 和 00000000 表示的都是 0,即-0和+0。

反码

由于原码中,+x和-x使用二进制加法(利用加法电路)相加不能等于 0,设计了反码,即:如果是正数则保持不变,如果是负数,则除符号位之外按位取反。这样正负 2 数相加就变成了 11111111 ,也就是-0,注意这里的结果也是反码。

补码

补码的定义就是正数和 0 的补码就是原码,负数的补码是其反码 +1。-1 的原码是 10000001,反码是 11111110,补码在反码的基础上 +1,即为 11111111。-0 取补码后跟 0 是一致的,没有了两个 0 的问题,没了-0 后多出的10000000表示-128,真值数也变回了 256。这也就是我们今天计算机所用的存储和计算的方式

由于高位溢出舍弃,采用补码的方式,无论是从11111111(-1)到00000000(0),还是从01111111(127)到100000000(-128)都是连续的,所有数其实是一个类似钟表上数字的闭合的环。0 是 0 点位置,-128 是 6 点位置。反码、补码,通过数学上的同余定理中的同余式相加,达到了用加法来实现减法的效果。

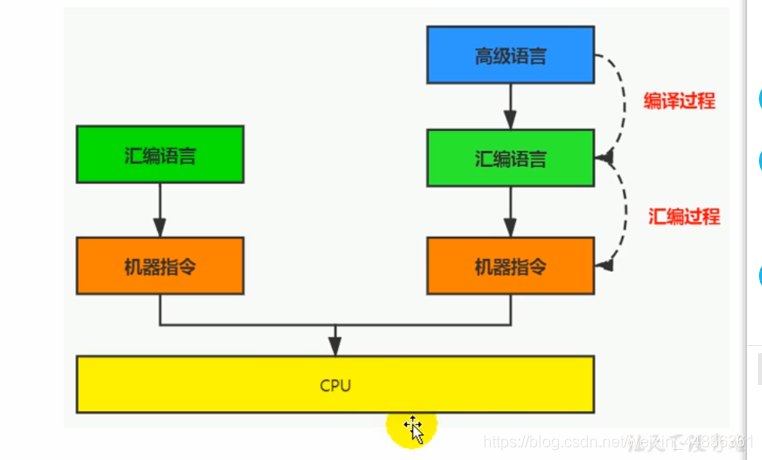

3.指令,汇编语言,机器码有什么区别和联系

指令

1.机器码由 0 和 1 组成的二进制序列,其可读性差,但运行速度快,为方便阅读,人们发明了指令。

2.指令就是把机器码中特定的 0 和 1 序列简化为对应的指令,一般为英文缩写。如 jmp,add,mov 等。

3.不同平台对应的同一操作的机器码可能不同。

指令集

1.不同平台所支持的指令有所差异,把每个平台所支持的指令,称为该平台对应的指令集

2 常见的指令集

x86 指令集,对应的是x86 框架的平台

ARM 指令集,······

汇编语言

1.在提高指令阅读性的基础上,又发明了汇编语言

2.用助记符代替机器指令的操作码,用地址符号或标号代替指令或操作数的地址

编译原理

1.C 语言是怎么进行编译的

高级语言 → 汇编语言 → 机器语言(二进制)

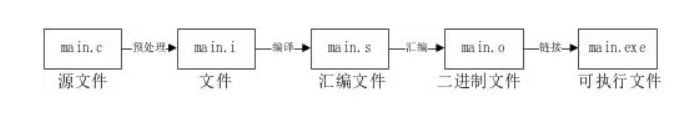

1.预处理

由.c 文件到.i 文件,这个过程叫预处理。在源文件被编译前,首先要进行预处理的工作,也就是对源代码进行相对应的展开、替换和清理。

① 在这个过程中,主要处理的事情:

② 把代码注释部分去掉,不让其参与编译

③ 将所有的#define 删除,并且展开所有的宏定义,简单来说就是字符替换

④ 处理所有的条件编译指令,例如#ifdef、#ifndef、#endif,简单来说就是带#的那些

⑤ 把“stdio.h”文件包含进来,即用“stdio.h”中的内容替换在“#include”位置

2.编译

由.i 文件到.s 文件,这个过程叫编译。编译的过程实质上是把高级语言翻译成机器语言的过程。简单来说,源文件被预处理之后,再以字符流的形式进行处理,进行词法和语法的分析,然后通过汇编器将源代码指令转变成汇编指令、生成相应的汇编文件。

3.汇编

由.s 文件到.o 文件,这个过程叫汇编。汇编是指把汇编语言代码翻译成目标机器指令的过程,也就是把汇编码转换成机器所能识别的二进制,通过把经过汇编之后生成的文件称为目标文件。

4.链接

由.o 文件到可执行文件,这个过程叫链接。经过汇编之后生成的目标文件并不能立即被执行,还需要由链接器将代码在执行过程中用到的其他目标代码及库文件进行链接,最终生成一个可执行程序。

假如.c 文件中有用到 printf 函数,那么就需要找到包含该函数的标准库文件,对它进行链接。

2.词法分析和文法分析

https://zhuanlan.zhihu.com/p/31096468

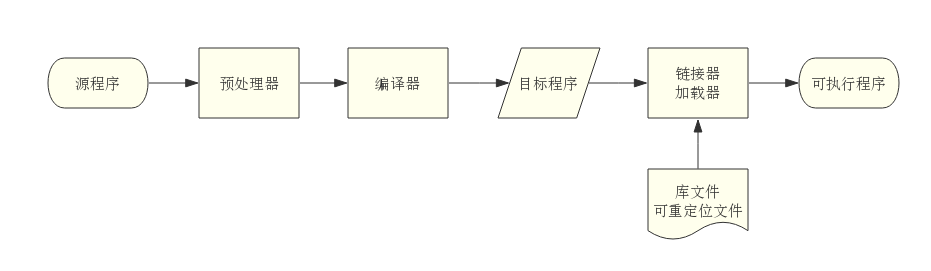

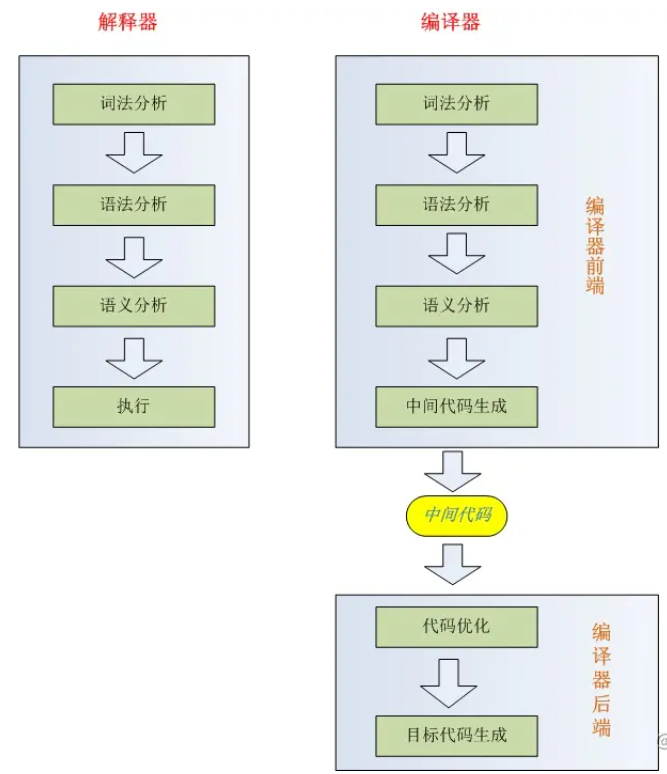

什么是编译器?

对外部来说,编译器是一个黑盒子,能够把一种源语言翻译为语义上等价的另一种目标语言。从现代高级编译器的角度讲,源语言是高级程序设计语言,容易阅读与编写,而目标语言是机器语言,即二进制代码,能够被计算机直接识别。从语言系统的处理角度来看,由源程序生成可执行程序的整体工作流程如图 1 所示:

其中,编译器又分为前端和后端两个部分。前端包括词法分析、语法分析、语义分析、中间代码生成,具有机器无关性,比较有代表性的工具是 Flex、Bison。后端包括中间代码优化、目标代码生成,具有机器相关性,比较有代表性的工具是 LLVM。在 Web 前端工程领域,由于宿主环境浏览器与 Node.js 的跨平台特性,我们只需关注编译器前端部分,就可以充分发挥它的应用价值。为了更好地理解编译器前端的工作原理,本文将主要以目前被广泛使用的 Babel 为例,阐述它是如何将源代码编译为目标代码。

Babel

作为新生代 ES 语法编译器,Babel 在前端工具链中占据了非常重要的地位,它严格按照 ECMA-262 语言规范,实现对最新语法的解析,而无需等待浏览器升级来提供对新特性的支持。Babel 内部所使用的语法解析器是 Babylon,抽象语法树(简写为 AST)的结点类型定义则参考了 Mozilla JS 引擎 SpiderMonkey,并对其进行扩展增强,且支持对 Flow、JSX、TypeScript 语法的解析。它所使用的 Babylon 实现了编译器中两个部分,词法分析和语法分析。

词法分析

词法分析是处理源程序的第一部分,主要任务是逐个扫描输入字符,转换为词法单元(Token)序列,传递给语法分析器进行语法分析。Token 是一个不可分割的最小单元。例如 var 这三个字符,它只能作为一个整体,语义上不能再被分解,因此它是一个 Token。每个 Token 对象都有能够被单独识别的类型属性和其它附加属性(操作符优先级、行列号等)。在 Babylon 词法分析器里,每个关键字是一个 Token ,每个标识符是一个 Token,每个操作符是一个 Token,每个标点符号也都是一个 Token。除此之外,还会过滤掉源程序中的注释和空白字符(换行符、空格、制表符等)。

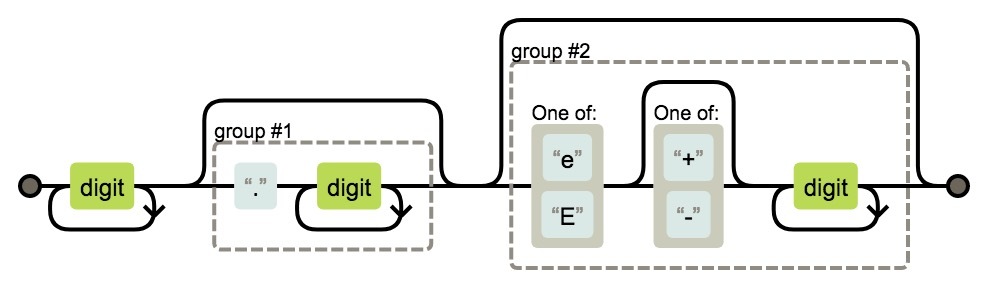

对于 Token 的匹配规则,可以根据正则表达式来描述。举个例子,要匹配一个 Number 类型的 Token,可以检测是否以 [0-9] 开头,接着循环或递归扫描紧连的后续字符,且需要特别留意 0b、0o、0x 开头的非十进制数值、科学计数法 e 或 E、小数点等特殊字符,指针不断后移直至不满足匹配规则或者到达行末尾。最后生成一个 Number 类型的 Token,附带值、文件位置等属性,并加入到 Token 序列中,继续下一轮扫描。

一个简单的 Number 类型状态转换如图 2 所示:

当然除了 Babylon 手写词法分析器之外,这个过程还可以采用有穷自动机(DFA/NFA)的方式实现,通过词法分析器生成器,把输入程序(模式匹配规则)自动转换成一个词法分析器,这里不展开阐述。

语法分析

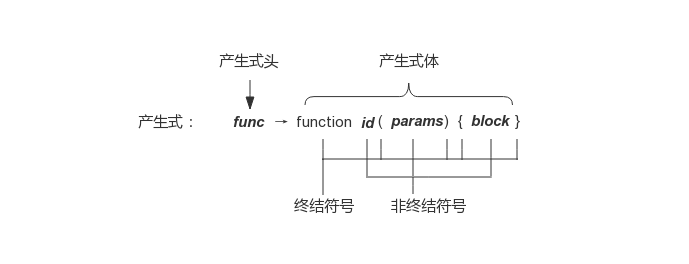

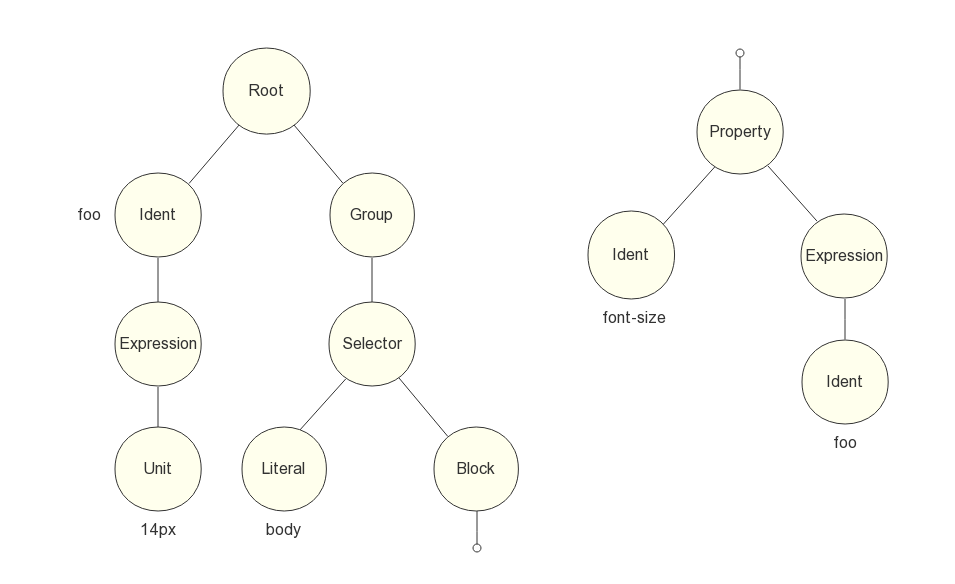

语法分析是词法分析的下一步,主要任务是扫描来自词法分析器产生的 Token 序列,根据文法和结点类型定义构造出一棵 AST,传递给编译器前端余下部分。文法描述了程序设计语言的构造规则,用于指导整个语法分析的过程。它由四个部分组成,一组终结符号(也称 Token)、一组非终结符号、一组产生式和一个开始符号。例如,函数声明语句的产生式表示形式如图 3 所示:

根据文法,语法分析器将 Token 逐个读入,不断替换文法产生式体的非终结符号,直至全部将非终结符号替换为终结符号,这个过程被称为推导。推导又分为两种方式,最左推导和最右推导。如果总是优先替换产生式体最左侧的非终结符号,被称为最左推导,如果总是优先替换产生式体最右侧的非终结符号,被称为最右推导。

语法分析器按照工作方式来划分,分为自顶向下分析法和自底向上分析法。自顶向下分析法要求通过最左推导从顶部 ( 根结点 ) 开始构造 AST,常用的分析器有递归下降语法分析器、 LL 语法分析器。而自底向上分析法要求通过最右推导从底部 ( 叶子结点 ) 开始构造 AST,常用的分析器有 LR 语法分析器、SLR 语法分析器、LALR 语法分析器。这两种分析方式在 Babylon 中都有所实践。

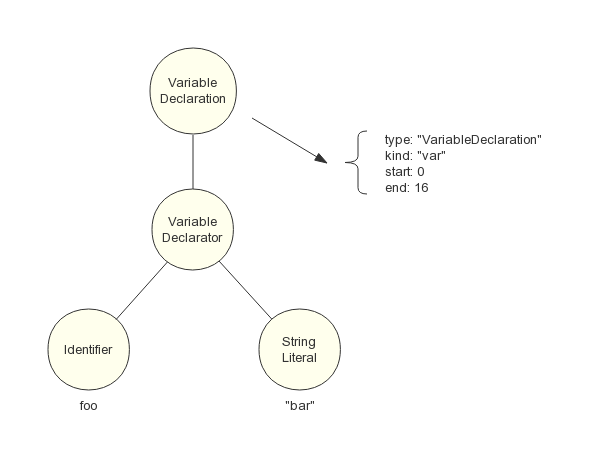

首先是自顶向下分析法,例如变量声明语句:

var foo = "bar";

经由词法分析器处理后,会生成 Token 序列:

Token("var");

Token("foo");

Token("=");

Token('"bar"');

Token(";");

由 LL(1) 语法分析器进行递归下降分析,每次向前查看一个输入 Token,来决定该用哪种产生式展开。对于变量声明语句的 FIRST 集合(推导结果的首个 Token 集合),只需检查输入 Token 为 Token('var')、Token('let')、Token('const') 三者其中之一,那么就使用该产生式展开。首先构造 AST 最顶层结点 VariableDeclaration,把 Token('var') 的值加入到该结点属性中, 接着逐个读入其余 Token,根据产生式的非终结符号从左到右的顺序,依次构造它的子结点,不断递归下降分析,直至所有 Token 读入完毕。最后生成的一棵 AST 如图 4 所示:

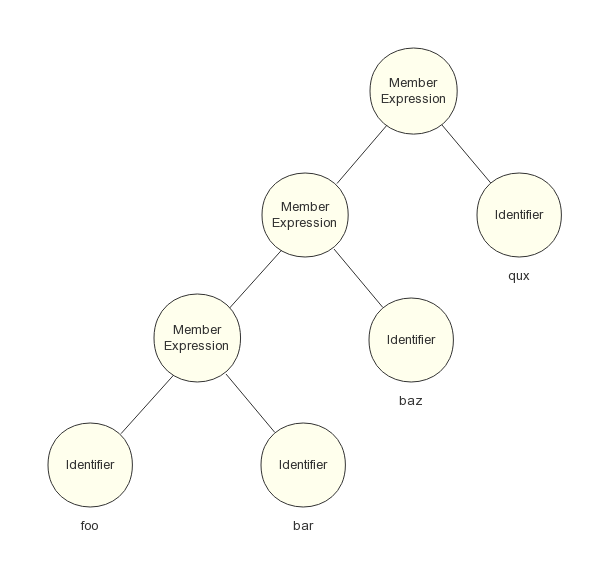

另一种是自底向上分析法,例如成员表达式语句:

foo.bar.baz.qux;

我们都知道这条语句等价于:

foo.bar.baz.qux;

而不是:

foo.(bar.(baz.qux))

原因就在于它所设计的文法是左递归的,而 LL 语法分析器是无法做到解析左递归的文法,这时候只能使用 LR 语法分析器的方式,自底向上地构造 AST。LR 语法分析器的核心是移入 - 归约分析技术,通过维护一个栈,由下一个输入 Token 来决定是把它移入栈中还是将栈顶的部分符号进行归约(把产生式体替换为产生式头),先构造子结点,再构造父结点,直至栈中所有符号全部归约。最后生成的一棵 AST 如图 5 所示:

此外,由 Babylon 构建的完整的 AST 还拥有特殊顶层结点 File 和 Program,它们描述了文件的基本信息、模块类型等等。

生成代码

工业级别的语言编译器,通常还会有语义分析阶段,检查程序上下文是否和语言所定义的语义一致,比如类型检查,作用域检查,另一个则是生成中间代码,比如三地址代码,用地址和指令来线性描述程序。但由于 Babel 的定位仅仅是对 ES 语法的转换,这一部分工作可以交给 JS 解释器引擎来处理。而 Babel 最为特色的部分是它的插件机制,针对不同的浏览器版本环境,调用不同的 Babel 插件。通过访问者模式(一种设计模式)的接口定义,对 AST 进行一遍深度优先遍历,对指定的匹配到的结点进行修改、删除、新增、移位,使原先的 AST 转换为另一棵经过修改的 AST。

一个访问者模式的接口定义如下:

visitor: {

Identifier(path) {

enter() {

//遍历AST进入Identifier结点时执行

...

},

exit() {

//遍历AST离开Identifier结点时执行

...

}

},

...

}

最后一个阶段则是生成目标代码,从 AST 的根结点出发,递归下降遍历,对每个结点都调用一个相关函数,执行语义动作,不断打印代码片段,最终生成目标代码,即经过 babel 编译后的代码。

模板引擎

再讲到模板引擎,最早诞生于服务端动态页面的开发,如 JSP、PHP、ASP 等模板引擎,自 Node.js 快速发展以后,前端界又产出了非常多的轮子,包括 EJS、Handlebars、Pug (前身为 Jade)、Mustache 等等,数不胜数。模板引擎技术使得结合数据渲染视图变得更加灵活,给逻辑的抽象带来了更多的可能性,数据与内容互不依赖。模板引擎的实现方式有很多种,比较简单的模板引擎,直接利用字符串替换、拼接的方式实现,比较复杂的模板引擎,例如 Pug,则会有比较完整的词法分析和语法分析过程,将模板预编译成 JS 代码再去动态执行。

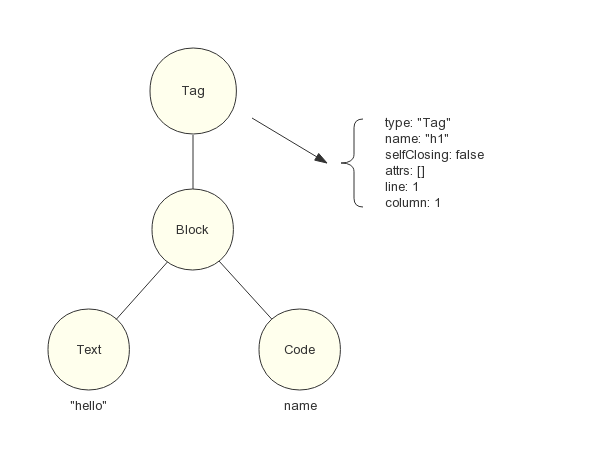

例如模板语句:

h1 hello #{name}

经由 Pug 解析器生成的 AST 如图 6 所示:

生成器生成的目标代码为(伪代码):

"<h1>" + "hello" + name + "<h1>";

运行时再调用 new Function 来动态执行代码:

var compiledFn = new Function(

"local",

`

with (local) {

return '<h1>' + 'hello' + name + '<h1>';

}

`

);

compiledFn({

name: "world",

});

最后输出 HTML 语句:

<h1>hello world</h1>

整个过程由两部分组成,预编译阶段和运行时阶段。当然一个好的模板引擎还会考虑功能、性能与安全兼备,上面的with语句是要避免的,还要引入缓存机制,XSS 防范机制,以及更加强大、友好、易于使用的语法糖。

另外值得一提的是以 Angular、React、Vue 为代表的前端 MVVM 框架,无一不引入了模板编译技术。Vue 作为渐进式的前端解决方案,受到众多开发者们的青睐,它对视图的渲染提供了渲染函数和模板两种方式。使用渲染函数需要调用核心 API 来构建 Virtual DOM 类型,过程相对复杂,编码量非常大,一旦 DOM 层次嵌套过深,就会造成代码难以掌控和维护的局面。为了应对这种复杂性,另一种方式则是编写基于 HTML 的模板,并加入 Vue 特有的标签、指令、插值等语法,由编译器来进行从模板到渲染函数的编译和优化,相对前者更优雅、便捷、易于编码。

CSS 预处理器

前端布局方式从刀耕火种的纯 CSS 年代演进到以 Sass、Less、Stylus 为代表的预处理语言,赋予了 CSS 可编程的能力,定义变量,函数,表达式计算、模块化等特性,极大地提升了开发人员的生产效率。这些都是编译技术所带来的变化。同样,编译器对原样式代码进行词法分析,产生 Token 序列。接着,语法分析,生成中间表示,一棵符合定义的 AST。同时,还会为每个程序块建立一个符号表来记录变量的名字,属性,为代码生成阶段的变量作用域分析提供帮助。最后,递归下降访问 AST,生成能够在浏览器环境中直接执行的 CSS 代码。

以预处理器 Stylus 语法为例:

foo = 14px

body

font-size foo

编译生成的 AST 为图 7 所示:

最后生成的目标代码为:

body {

font-size: 14px;

}

看似简单容易的代码转换背后,编译器为我们做了许多语法层面的处理,给 CSS 带来了从未有过的强大的扩展能力,以及底层对编译速度的持续优化,让 CSS 的编写方式更加简洁高效,易于维护和管理。

3.js 预编译原理

首先 JavaScript 这个预编译和传统的编译是不一样的(可以把 js 预编译理解为特殊的编译过程)

- 我们应该已经知道:JavaScript 是解释型语言。(解释型语言,就是编译一行,执行一行)

- 传统的编译会经历很多步骤,分词、解析、代码生成什么的

- 下面就给大家分享一下我所理解的 JS 预编译

JavaScript 运行三部曲 脚本执行 js,引擎都做了什么呢?

- 语法分析

先全部扫一遍 看有没有语法错误.

2.预编译(执行前一刻)

变量 声明提升 函数声明整体提升

3.解释执行

解释一行执行一行

函数中:预编译执行四部曲

- 创建 AO 对象 (Activation Object (执行期上下文))

- 找形参和变量声明,将变量和形参名作为 AO 属性名,值为 undefined

- 将实参值和形参统一

- 在函数体里面找函数声明,值赋予函数体

全局中:预编译三部曲

- 创建 GO 对象(Global Object window 就是全局)

- 找变量声明,将变量声明作为 GO 对象的属性名,值赋予 undifined

- 找全局里的函数声明,将函数名作为 GO 对象的属性名,值赋予函数体

实例分析

<script>

var a = 1;

console.log(a);

function test(a) {

console.log(a);

var a = 123;

console.log(a);

function a() {}

console.log(a);

var b = function() {}

console.log(b);

function d() {}

}

var c = function (){

console.log("I at C function");

}

console.log(c);

test(2);

</script>

分析过程如下:

- 页面产生便创建 GO 全局对象(Global Object)(也就是 window 对象);

- 第一个脚本文件加载;

- 脚本加载完毕后,分析语法是否合法;

- 开始预编译

- 查找变量声明,作为 GO 属性,值赋予 undefined;

- 查找函数声明,作为 GO 属性,值赋予函数体;

全局预编译结束后,GO 中存储的值

//抽象描述

GO/window = {

a: undefined,

c: undefined,

test: function(a) {

console.log(a);

var a = 123;

console.log(a);

function a() {}

console.log(a);

var b = function() {}

console.log(b);

function d() {}

}

}

解释执行代码(直到执行完 test(2)语句)

GO/window = {

a: 1,

c: function (){

console.log("I at C function");

}

test: function(a) {

console.log(a);

var a = 123;

console.log(a);

function a() {}

console.log(a);

var b = function() {}

console.log(b);

function d() {}

}

}

执行函数 test()之前,再次发生预编译

根据函数中:预编译执行四部曲可知

预编译第一和第二两小步如下:

//抽象描述

AO = {

a: undefined,

b: undefined,

};

预编译之第 3 步如下:

//抽象描述

AO = {

a: 123,

b: undefined,

};

预编译之第 4 步如下:

//抽象描述

AO = {

a:function a() {},

b:undefined

d:function d() {}

}

执行 test()函数时如下过程变化:

//抽象描述

AO = {

a:function a() {},

b:undefined

d:function d() {}

}

--->

AO = {

a:123,

b:undefined

d:function d() {}

}

--->

AO = {

a:123,

b:function() {}

d:function d() {}

}

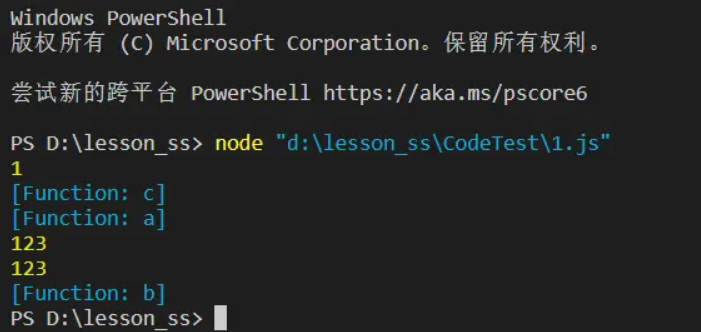

执行结果:

注意: 预编译阶段发生变量声明和函数声明,没有赋值行为,匿名函数不参与预编译 ;只有在解释执行阶段才会进行变量初始化 。

预编译小节

- 预编译两个小规则

- 函数声明整体提升—(无论函数调用和声明的位置是前是后,系统总会把函数声明移到调用前面)

- 变量 声明提升—(无论变量调用和声明的位置是前是后,系统总会把声明移到调用前,注意仅仅只是声明,所以值是 undefined)

- 预编译前奏

- 即任何变量,如果未经声明就赋值,则此变量就位全局变量所有。(全局域就是 Window)

- 一切声明的全局变量,全是 window 的属性,如:var a=12;等同于 Window.a = 12;

- 函数预编译发生在函数执行前一刻。

4.v8 引擎是怎么编译 js 的

一个接受 Javascript 代码,编译代码然后执行的 C++程序,编译后的代码可以在多种操作系统多种处理器上运行

主要工作

- 编译 js 代码

- 处理调用栈

- 内存分配

- 垃圾的回收

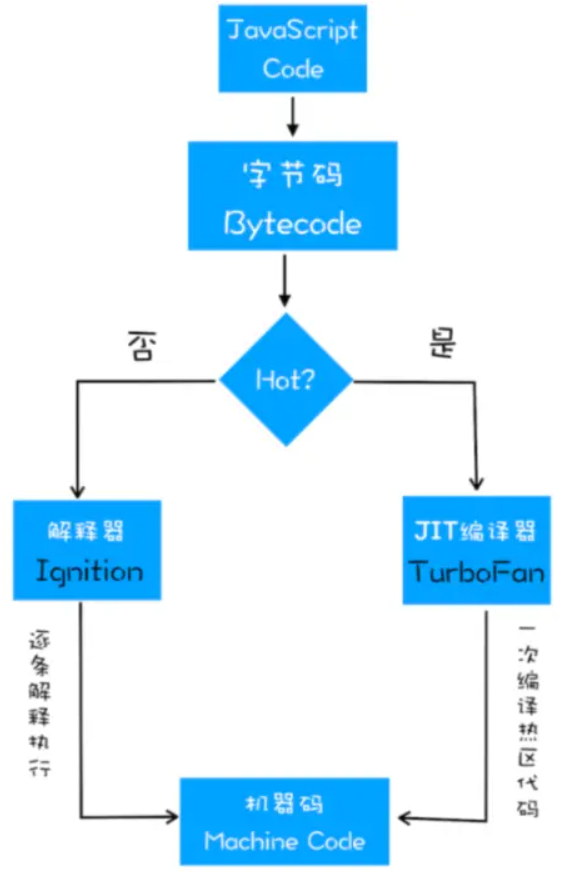

重要组件

大部分 js 引擎在编译和执行 js 代码,都会用到三个重要的组件

- 解析器:负责将 JS 源代码解析成抽象语法树(AST)

- 解释器: 负责将 AST 解释成字节码 bytecode,同时解释器也有直接解释执行 bytecode 的能力

- 编译器:负责编译出运行更加高效的机器代码

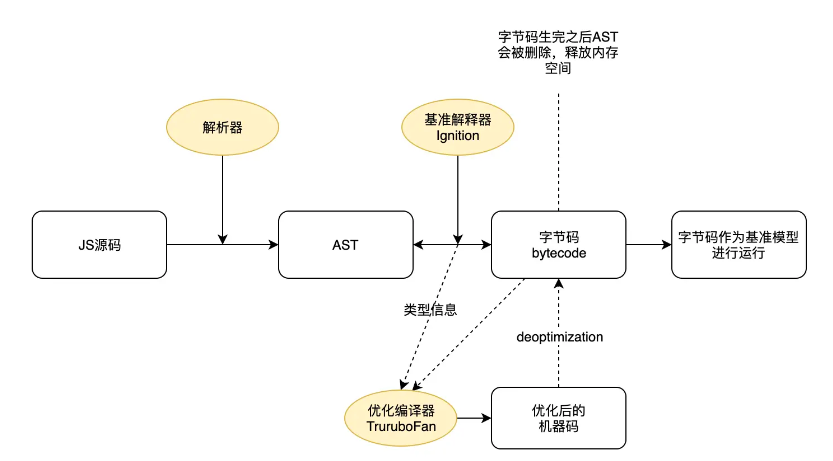

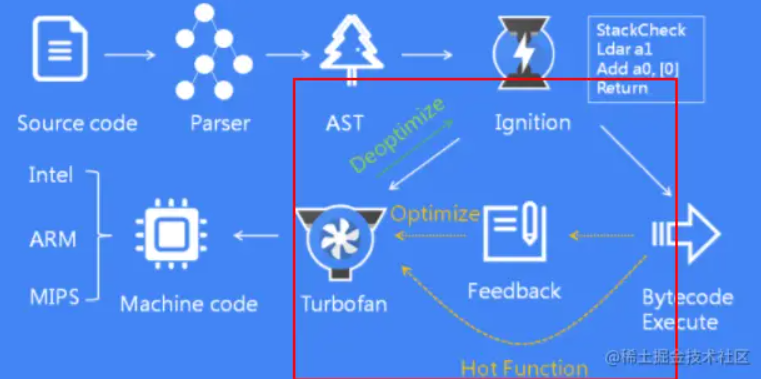

优化后的 V8

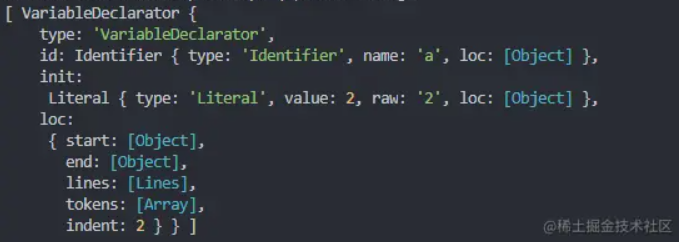

语法树的解析还是基本保持一致的,但在获得抽象语法树之后,v8 引擎加入了解释器 Ignition,语法树通过解释器 Ignition 生成了 bytecode 字节码,此时 AST 就被清除掉了,释放内存空间,生成 bytecode 直接被解释器执行,同时生成的 bytecode 将作为基准执行模型,字节码更加简洁。生成的 bytecode 大小相当于等效的基准机器代码的 25 到 50%左右。

在代码不断运行过程中,解释器收集到了很多可以用来优化代码的信息,比如变量的类型、那些函数执行的频率较高,这些信息被发送给编译器 TruboFan,编译起 TruboFan 会根据这些信息来编译出经过优化的机器代码。

优化的机器码也有可能被反向编译为字节码,这个过程叫 deoptimization

优化策略

- 函数只声明未被调用,不会被解析成 AST

- 函数只被调用一次,bytecode 直接被解释执行

- 如果函数被调用多次,可能会被标记为热点函数,可能会被编译成机器代码

优点

- 由于不需要直接编译成机器码,而是使用了中间层的字节码,字节码生成速度远远大于机器吗,所以网页初始化解析执行 js 的时间缩短了

- 在生成的优化机器代码时,不需要再从源码开始编译,而是直接使用字节码编译。而且需要 deoptimization 时,只需要回归到中间层字节码解释执行就可以了

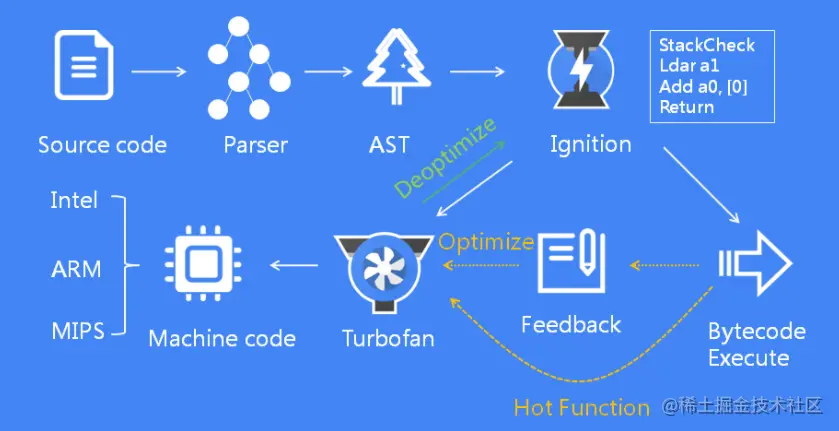

- 首先 V8 引擎会扫描所有的源代码,进行词法分析,生成 Tokens;

- Parser 解析器根据 Tokens 生成 AST;

- Ignition 解释器将 AST 转换为字节码,并解释执行;

- TurboFan 编译器负责将热点函数优化编译为机器指令执行;

词法分析

V8 引擎首先会扫描所有的源代码,进行词法分析(词法分析是通过 Scanner 模块来完成的,本文不进行详细介绍)。

什么是词法分析?

词法分析(Tokenizing/Lexing)其作用是将一行行的源码拆解成一个个 token。所谓词法单元 token,指的是语法上不可能再分的、最小的单个字符或字符串。

ECMAScript 中明确定义了 Token 包含的内容。

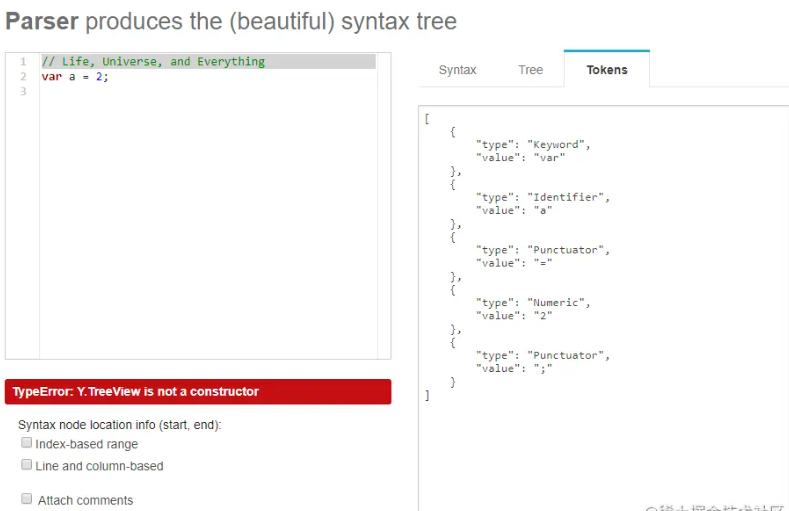

我们来看下var a = 2; 这句代码经过词法分析后会被分解出哪些 tokens ?

从上图中可以看到,这句代码最终被分解出了五个词法单元:

var关键字a标识符=运算符(符号)2数值;分号(符号)

Tokens 在线查看网站:esprima.org/demo/parse.…

语法分析

Parser

Parser 是 V8 的解析器,负责根据生成的 Tokens 进行语法分析。Parser 的主要工作包括:

分析语法错误:遇到错误的语法会抛出异常;

输出 AST:将词法分析输出的词法单元流(数组)转换为一个由元素逐级嵌套所组成的代表了程序语法结构的树——抽象语法树(Abstract Syntax Tree, AST);

确定词法作用域;

生成执行上下文;

什么是抽象语法树(Abstract Syntax Tree, AST)?

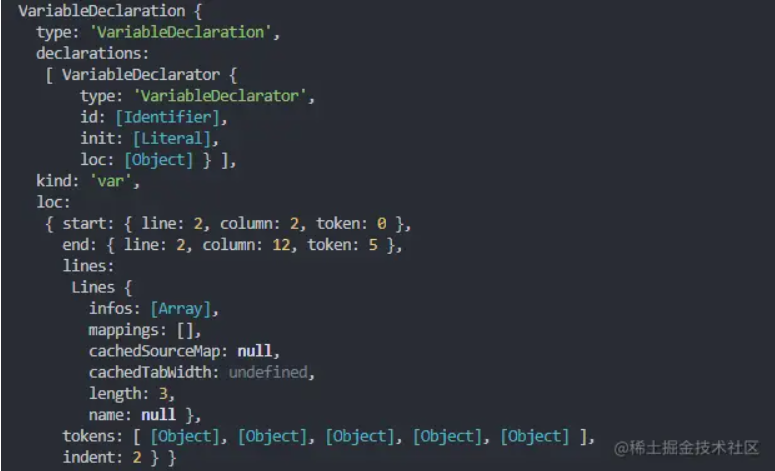

还是上面的例子,我们来看下 var a = 2; 经过语法分析后生成的 AST 是什么样子的:

可以看到这段程序的类型是 VariableDeclaration,也就是说这段代码是用来声明变量的。

AST 在线查看网站:astexplorer.net/

AST 的结构和代码的结构非常相似,其实你也可以把 AST 看成代码的结构化表示,编译器或者解释器后续的工作都需要依赖于 AST,而不是源代码。

AST 是非常重要的一种数据结构,在很多项目中有着广泛的应用。其中最著名的一个项目就是 Babel。Babel 是一个被广泛使用的代码转码器,可以将 ES6 代码转为 ES5 代码,这意味着你可以现在就用 ES6 编写程序,而不用担心现有环境是否支持 ES6。Babel 的工作原理就是先将 ES6 源码转换为 AST,然后再将 ES6 语法的 AST 转换为 ES5 语法的 AST,最后利用 ES5 的 AST 生成 JavaScript 源代码。 除了 Babel 外,还有 ESLint 也使用 AST。ESLint 是一个用来检查 JavaScript 编写规范的插件,其检测流程也是需要将源码转换为 AST,然后再利用 AST 来检查代码规范化的问题。

Pre-Parser

什么是预解析 Pre-Parser?

我们先来看看下面这段代码:

function foo() {

console.log("function foo");

}

function bar() {

console.log("function bar");

}

foo();

上面这段代码中,如果使用 Parser 解析后,会生成 foo 函数 和 bar 函数的 AST。然而 bar 函数并没有被调用,所以生成 bar 函数的 AST 实际上是没有任何意义且浪费时间的。那么有没有办法解决呢?此时就用到了 Pre-Parser 技术。

在 V8 中有两个解析器用于解析 JavaScript 代码,分别是 Parser 和 Pre-Parser 。

- Parser 解析器又称为 full parser(全量解析) 或者 eager parser(饥饿解析)。它会解析所有立即执行的代码,包括语法检查,生成 AST,以及确定词法作用域。

- Pre-Parser 又称为惰性解析,它只解析未被立即执行的代码(如函数),不生成 AST ,只确定作用域,以此来提高性能。当预解析后的代码开始执行时,才进行 Parser 解析。

我们还是以示例来说明:

function foo() {

console.log('a');

function inline() {

console.log('b')

}

}

(function bar() {

console.log('c')

})();

foo();

- 当 V8 引擎遇到 foo 函数声明时,发现它未被立即执行,就会采用 Pre-Parser 对其进行解析(inline 函数同)。

- 当 V8 遇到

(function bar() {console.log(c)})()时,它会知道这是一个立即执行表达式(IIFE),会立即被执行,所以会使用 Parser 对其解析。 - 当 foo 函数被调用时,会使用 Parser 对 foo 函数进行解析,此时会对 inline 函数再进行一次预解析,也就是说 inline 函数被预解析了两次。如果嵌套层级较深,那么内层的函数会被预解析多次,所以在写代码时,尽可能避免嵌套多层函数,会影响性能。

Ignition

Ignition 是 V8 的解释器,它负责的工作包括:

- 将 AST 转换为中间代码(字节码 Bytecode)

- 逐行解释执行字节码:在该阶段,就已经可以开始执行 JavaScript 代码了。

什么是字节码?

字节码(Bytecode)是介于 AST 和机器码之间的一种中间码,它比机器码更抽象,也更轻量,需要直译器转译后才能成为机器码。

早期版本的 V8 ,并没有生成中间字节码的过程,而是直接将 AST 转换为机器码,由于执行机器码的效率是非常高效的,所以这种方式在发布后的一段时间内运行效果是非常好的。但是随着 Chrome 在手机上的广泛普及,特别是运行在 512M 内存的手机上,内存占用问题也暴露出来了,因为 V8 需要消耗大量的内存来存放转换后的机器码。为了解决内存占用问题,V8 团队大幅重构了引擎架构,引入字节码,并且抛弃了之前的编译器,最终花了将进四年的时间,实现了现在的这套架构。

从图中可以看出,机器码所占用的空间远远超过了字节码,所以使用字节码可以减少系统内存的占用。

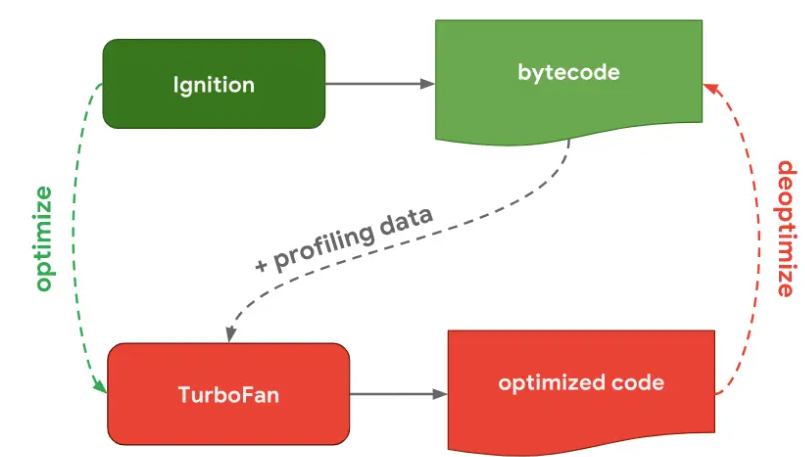

TurboFan

TurboFan 是 V8 的优化编译器,负责将字节码和一些分析数据作为输入并生成优化的机器代码。

上面我们说到,当 Ignition 将 JavaScript 代码转换为字节码后,程序就可以执行了,那么 TurboFan 还有什么用呢?

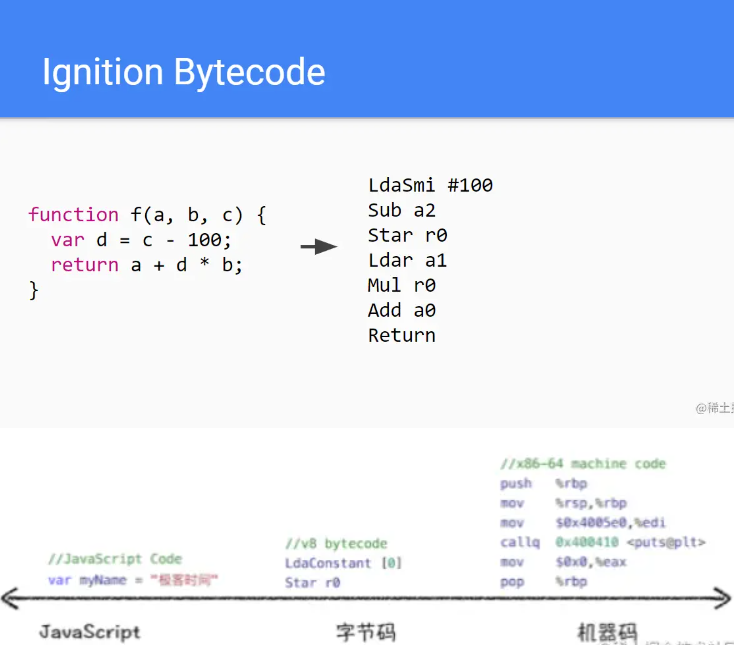

我们再来看下 V8 的工作流程图:

我们主要关注 Ignition 和 TurboFan 的交互:

当 Ignition 开始执行 JavaScript 代码后,V8 会一直观察 JavaScript 代码的执行情况,并记录执行信息,如每个函数的执行次数、每次调用函数时,传递的参数类型等。

如果一个函数被调用的次数超过了内设的阈值,监视器就会将当前函数标记为热点函数(Hot Function),并将该函数的字节码以及执行的相关信息发送给 TurboFan。TurboFan 会根据执行信息做出一些进一步优化此代码的假设,在假设的基础上将字节码编译为优化的机器代码。如果假设成立,那么当下一次调用该函数时,就会执行优化编译后的机器代码,以提高代码的执行性能。

V8 的解释器和编译器的取名也很有意思。解释器 Ignition 是点火器的意思,编译 TurboFan 是涡轮增压的意思,寓意着代码启动时通过点火器慢慢发动,一旦启动,涡轮增压介入,其执行效率随着执行时间越来越高效率,因为热点代码都被编译器 TurboFan 转换了机器码,直接执行机器码就省去了字节码“翻译”为机器码的过程。我们把这种技术称为即时编译(JIT)

那如果假设不成立呢?不知道你们有没有注意到上图中有一条由 optimized code 指向 bytecode 的红色指向线。此过程叫做 deoptimize(优化回退),将优化编译后的机器代码还原为字节码。

读到这里,你可能有些疑惑:这个假设是什么假设呢?以及为什么要优化回退?我们来看下面的例子。

function sum(a, b) {

return a + b;

}

我们都知道 JavaScript 是基于动态类型的,a 和 b 可以是任意类型数据,当执行 sum 函数时,Ignition 解释器会检查 a 和 b 的数据类型,并相应地执行加法或者连接字符串的操作。

如果 sum 函数被调用多次,每次执行时都要检查参数的数据类型是很浪费时间的。此时 TurboFan 就出场了。它会分析监视器收集的信息,如果以前每次调用 sum 函数时传递的参数类型都是数字,那么 TurboFan 就预设 sum 的参数类型是数字类型,然后将其编译为机器指令。

但是当某一次的调用传入的参数不再是数字时,表示 TurboFan 的假设是错误的,此时优化编译生成的机器代码就不能再使用了,于是就需要进行优化回退。

Orinoco

Orinoco 是 V8 的垃圾回收模块(garbage collector),负责将程序不再需要的内存空间回收(标记清除法);

5.编译型语言和解释型语言

所谓的二进制指令,也就是机器码,是 CPU 能够识别的硬件层面的“代码”,简陋的硬件(比如古老的单片机)只能使用几十个指令,强大的硬件(PC 和智能手机)能使用成百上千个指令。

然而,究竟在什么时候将源代码转换成二进制指令呢?不同的编程语言有不同的规定:

- 有的编程语言要求必须提前将所有源代码一次性转换成二进制指令,也就是生成一个可执行程序(Windows 下的 .exe),比如 C 语言、C++、Golang、Pascal(Delphi)、汇编等,这种编程语言称为编译型语言,使用的转换工具称为编译器。

- 有的编程语言可以一边执行一边转换,需要哪些源代码就转换哪些源代码,不会生成可执行程序,比如 Python、JavaScript、PHP、Shell、MATLAB 等,这种编程语言称为解释型语言,使用的转换工具称为解释器。

简单理解,编译器就是一个“翻译工具”,类似于将中文翻译成英文、将英文翻译成俄文。但是,翻译源代码是一个复杂的过程,大致包括词法分析、语法分析、语义分析、性能优化、生成可执行文件等五个步骤

Java 和 C# 是一种比较奇葩的存在,它们是半编译半解释型的语言,源代码需要先转换成一种中间文件(字节码文件),然后再将中间文件拿到虚拟机中执行。Java 引领了这种风潮,它的初衷是在跨平台的同时兼顾执行效率;C# 是后来的跟随者,但是 C# 一直止步于 Windows 平台,在其它平台鲜有作为。

编译型语言

对于编译型语言,开发完成以后需要将所有的源代码都转换成可执行程序,比如 Windows 下的.exe文件,可执行程序里面包含的就是机器码。只要我们拥有可执行程序,就可以随时运行,不用再重新编译了,也就是“一次编译,无限次运行”。

在运行的时候,我们只需要编译生成的可执行程序,不再需要源代码和编译器了,所以说编译型语言可以脱离开发环境运行。

编译型语言一般是不能跨平台的,也就是不能在不同的操作系统之间随意切换。

编译型语言不能跨平台表现在两个方面:

1) 可执行程序不能跨平台

可执行程序不能跨平台很容易理解,因为不同操作系统对可执行文件的内部结构有着截然不同的要求,彼此之间也不能兼容。不能跨平台是天经地义,能跨平台反而才是奇葩。

比如,不能将 Windows 下的可执行程序拿到 Linux 下使用,也不能将 Linux 下的可执行程序拿到 Mac OS 下使用(虽然它们都是类 Unix 系统)。

另外,相同操作系统的不同版本之间也不一定兼容,比如不能将 x64 程序(Windows 64 位程序)拿到 x86 平台(Windows 32 位平台)下运行。但是反之一般可行,因为 64 位 Windows 对 32 位程序作了很好的兼容性处理。

2) 源代码不能跨平台

不同平台支持的函数、类型、变量等都可能不同,基于某个平台编写的源代码一般不能拿到另一个平台下编译。我们以 C 语言为例来说明。

【实例 1】在 C 语言中要想让程序暂停可以使用“睡眠”函数,在 Windows 平台下该函数是 Sleep(),在 Linux 平台下该函数是 sleep(),首字母大小写不同。其次,Sleep() 的参数是毫秒,sleep() 的参数是秒,单位也不一样。

以上两个原因导致使用暂停功能的 C 语言程序不能跨平台,除非在代码层面做出兼容性处理,非常麻烦。

【实例 2】虽然不同平台的 C 语言都支持 long 类型,但是不同平台的 long 的长度却不同,例如,Windows 64 位平台下的 long 占用 4 个字节,Linux 64 位平台下的 long 占用 8 个字节。

我们在 Linux 64 位平台下编写代码时,将 0x2f1e4ad23 赋值给 long 类型的变量是完全没有问题的,但是这样的赋值在 Windows 平台下就会导致数值溢出,让程序产生错误的运行结果。

让人苦恼的,这样的错误一般不容易察觉,因为编译器不会报错,我们也记不住不同类型的取值范围。

解释型语言

对于解释型语言,每次执行程序都需要一边转换一边执行,用到哪些源代码就将哪些源代码转换成机器码,用不到的不进行任何处理。每次执行程序时可能使用不同的功能,这个时候需要转换的源代码也不一样。

因为每次执行程序都需要重新转换源代码,所以解释型语言的执行效率天生就低于编译型语言,甚至存在数量级的差距。计算机的一些底层功能,或者关键算法,一般都使用 C/C++ 实现,只有在应用层面(比如网站开发、批处理、小工具等)才会使用解释型语言。

在运行解释型语言的时候,我们始终都需要源代码和解释器,所以说它无法脱离开发环境。

当我们说“下载一个程序(软件)”时,不同类型的语言有不同的含义:

- 对于编译型语言,我们下载到的是可执行文件,源代码被作者保留,所以编译型语言的程序一般是闭源的。

- 对于解释型语言,我们下载到的是所有的源代码,因为作者不给源代码就没法运行,所以解释型语言的程序一般是开源的。

相比于编译型语言,解释型语言几乎都能跨平台,“一次编写,到处运行”是真是存在的,而且比比皆是。那么,为什么解释型语言就能快平台呢?

这一切都要归功于解释器!

我们所说的跨平台,是指源代码跨平台,而不是解释器跨平台。解释器用来将源代码转换成机器码,它就是一个可执行程序,是绝对不能跨平台的。

官方需要针对不同的平台开发不同的解释器,这些解释器必须要能够遵守同样的语法,识别同样的函数,完成同样的功能,只有这样,同样的代码在不同平台的执行结果才是相同的。

你看,解释型语言之所以能够跨平台,是因为有了解释器这个中间层。在不同的平台下,解释器会将相同的源代码转换成不同的机器码,解释器帮助我们屏蔽了不同平台之间的差异。

总结

我们将编译型语言和解释型语言的差异总结为下表:

| 类型 | 原理 | 优点 | 缺点 |

|---|---|---|---|

| 编译型语言 | 通过专门的编译器,将所有源代码一次性转换成特定平台(Windows、Linux 等)执行的机器码(以可执行文件的形式存在)。 | 编译一次后,脱离了编译器也可以运行,并且运行效率高。 | 可移植性差,不够灵活。 |

| 解释型语言 | 由专门的解释器,根据需要将部分源代码临时转换成特定平台的机器码。 | 跨平台性好,通过不同的解释器,将相同的源代码解释成不同平台下的机器码。 | 一边执行一边转换,效率很低。 |

解释器

解释器是一条一条的解释执行源语言(边解释边运行)。比如 php,postscritp,javascript 就是典型的解释性语言。 运行效率低,所以通常会进行一些预编译的优化。

编译器是把源代码整个编译成目标代码,执行时不在需要编译器,直接在支持目标代码的平台上运行,这样执行效率比解释执行快很多。比如 C 语言代码被编译成二进制代码(exe 程序),在 windows 平台上执行。

他们**最大的区别是程序运行时需要解释器边解释边执行,而编译器则在运行时是完全不需要的**。

他们**最大的区别是程序运行时需要解释器边解释边执行,而编译器则在运行时是完全不需要的**。解释器的优点是比较容易让用户实现自己跨平台的代码,比如 java,php 等,同一套代码可以在几乎所有的操作系统上执行,而无需根据操作系统做修改; 编译器的目的就是生成目标代码再由连接器生成可执行的机器码,这样的话需要根据不同的操作系统编制代码,虽然有像 Qt 这样的源代码级跨平台的编程工具库,但在不同的平台上仍然需要重新编译连接成可执行文件,但其执行效率要远远高于解释运行的程序

6.eslint 原理

我们在前端工程化中可以这样使用 ESLint:

- 基于业界现有的 ESLint 规范和团队代码习惯定制一套统一的 ESLint 代码规则

- 将统一代码规则封装成 ESLint 规则包接入

- 将 ESLint 接入脚手架、编辑器以及研发工作流中

ESLint 的用法包括两部分: 通过配置文件配置 lint 规则; 通过命令行执行 lint,找出不符合规范的地方

这是 eslint 的主要代码执行逻辑,主要流程如下:

解析命令行参数,校验参数正确与否及打印相关信息;

初始化 根据配置实例一个 engine 对象

CLIEngine实例;engine.executeOnFiles读取源代码进行检查,返回报错信息和修复结果。

后端开发理论

1.什么是 ioc 和 aop

IOC

概述

IoC (Inversion of control )控制反转/反转控制。它是一种思想不是一个技术实现。描述的是:Java 开发领域对象的创建以及管理的问题。

例如:现有类 A 依赖于类 B

- 传统的开发方式 :往往是在类 A 中手动通过 new 关键字来 new 一个 B 的对象出来

- 使用 IoC 思想的开发方式 :不通过 new 关键字来创建对象,而是通过 IoC 容器(Spring 框架) 来帮助我们实例化对象。我们需要哪个对象,直接从 IoC 容器里面过去即可。

从以上两种开发方式的对比来看:我们 “丧失了一个权力” (创建、管理对象的权力),从而也得到了一个好处(不用再考虑对象的创建、管理等一系列的事情)

为什么叫 控制反转

控制 :指的是对象创建(实例化、管理)的权力

反转 :控制权交给外部环境(Spring 框架、IoC 容器)

IoC 解决了什么问题

IoC 的思想就是两方之间不互相依赖,由第三方容器来管理相关资源。这样有什么好处呢?

- 对象之间的耦合度或者说依赖程度降低;

- 资源变的容易管理;比如你用 Spring 容器提供的话很容易就可以实现一个单例。

例如:现有一个针对 User 的操作,利用 Service 和 Dao 两层结构进行开发

在没有使用 IoC 思想的情况下,Service 层想要使用 Dao 层的具体实现的话,需要通过 new 关键字在UserServiceImpl 中手动 new 出 IUserDao 的具体实现类 UserDaoImpl(不能直接 new 接口类)。

开发过程中突然接到一个新的需求,针对对IUserDao 接口开发出另一个具体实现类。因为 Server 层依赖了IUserDao的具体实现,所以我们需要修改UserServiceImpl中 new 的对象。如果只有一个类引用了IUserDao的具体实现,可能觉得还好,修改起来也不是很费力气,但是如果有许许多多的地方都引用了IUserDao的具体实现的话,一旦需要更换IUserDao 的实现方式,那修改起来将会非常的头疼。

使用 IoC 的思想,我们将对象的控制权(创建、管理)交有 IoC 容器去管理,我们在使用的时候直接向 IoC 容器 “要” 就可以了

AOP

AOP:Aspect oriented programming 面向切面编程,AOP 是 OOP(面向对象编程)的一种延续。

下面我们先看一个 OOP 的例子。

例如:现有三个类,Horse、Pig、Dog,这三个类中都有 eat 和 run 两个方法。

通过 OOP 思想中的继承,我们可以提取出一个 Animal 的父类,然后将 eat 和 run 方法放入父类中,Horse、Pig、Dog通过继承Animal类即可自动获得 eat() 和 run() 方法。这样将会少些很多重复的代码。

OOP 编程思想可以解决大部分的代码重复问题。但是有一些问题是处理不了的。比如在父类 Animal 中的多个方法的相同位置出现了重复的代码,OOP 就解决不了

这部分重复的代码,一般统称为 横切逻辑代码。

横切逻辑代码存在的问题:

- 代码重复问题

- 横切逻辑代码和业务代码混杂在一起,代码臃肿,不变维护

AOP 另辟蹊径,提出横向抽取机制,将横切逻辑代码和业务逻辑代码分离

img

代码拆分比较容易,难的是如何在不改变原有业务逻辑的情况下,悄无声息的将横向逻辑代码应用到原有的业务逻辑中,达到和原来一样的效果。

AOP 解决了什么问题

通过上面的分析可以发现,AOP 主要用来解决:在不改变原有业务逻辑的情况下,增强横切逻辑代码,根本上解耦合,避免横切逻辑代码重复。

AOP 为什么叫面向切面编程

切 :指的是横切逻辑,原有业务逻辑代码不动,只能操作横切逻辑代码,所以面向横切逻辑

面 :横切逻辑代码往往要影响的是很多个方法,每个方法如同一个点,多个点构成一个面。这里有一个面的概念

2.前后端分离中,后端负责了什么

后端工作

后端专注于:后端控制层(Restful API) & 服务层 & 数据访问层;

前端专注于:前端控制层(Nodejs) & 视图层

1、项目设计阶段,前后端架构负责人将项目整体进行分析,讨论并确定 API 风格、职责分配、开发协助模式,确定人员配备;设计确定后,前后端人员共同制定开发接口。

2、项目开发阶段,前后端分离是各自分工,协同敏捷开发,后端提供 Restful API,并给出详细文档说明,前端人员进行页面渲染前台的任务是发送 API 请(GET,PUT,POST,DELETE 等)获取数据(json,xml)后渲染页面。

3、项目测试阶段,API 完成之前,前端人员会使用 mock server 进行模拟测试,后端人员采用 junit 进行 API 单元测试,不用互相等待;API 完成之后,前后端再对接测试一下就可以了,当然并不是所有的接口都可以提前定义,有一些是在开发过程中进行调整的。

4、项目部署阶段,利用 nginx 做反向代理,即 Java + nodejs + nginx 方式进行。

后端技术发展

互联网,尤其是移动互联网开始兴起以后,海量的用户呼啸而来,一个单机部署的小小 War 包肯定是撑不住了,必须得做分布式。

原来的单个 Tomcat 得变成 Tomcat 的集群,前边弄个 Web 服务器做请求的负载均衡,不仅如此,还得考虑状态问题,session 的一致性。

业务越来越复杂,我们不得不把某些业务放到一个机器(或集群)上,把另外一部分业务放到另外一个机器(或集群)上,虽然系统的计算能力,处理能力大大增强,但是这些系统之间的通信就变成了头疼的问题,消息队列(MQ),RPC 框架(如 Dubbo)应运而生,为了提高通信效率,各种序列化的工具(如 Protobuf)也争先空后地问世。

单个数据库也撑不住了,那就做数据库的读写分离,如果还不行,就做分库和分表,把原有的数据库垂直地切一切,或者水平地切一切, 但不管怎么切,都会让应用程序的访问非常麻烦,因为数据要跨库做 Join/排序,还需要事务,为了解决这个问题,又有各种各样“数据访问中间件”的工具和产品诞生。

为了最大程度地提高性能,缓存肯定少不了,可以在本机做缓存(如 Ehcache),也可以做分布式缓存(如 Redis),如何搞数据分片,数据迁移,失效转移,这又是一个超级大的主题了。

互联网用户喜欢上传图片和文件,还得搞一个分布式的文件系统(如 FastDFS),要求高可用,高可靠。

数据量大了,搜索的需求就自然而然地浮出水面,你得弄一个支持全文索引的搜索引擎(如 Elasticsearch ,Solr)出来。

林子大了,什么鸟都有,必须得考虑安全,数据的加密/解密,签名、证书,防止 SQL 注入,XSS/CSRF 等各种攻击。

后端模式

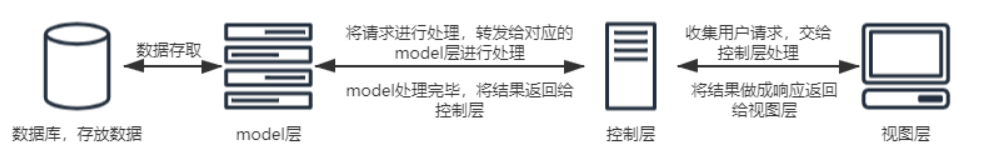

MVC 模式把一个 web 应用分成三个层面,分别是 control 层(控制层),model 层(模型层)和 view 层(视图层)

MVC 模式的三个层面分别负责不同的功能。模型层负责专门的业务处理,视图层负责专门的 UI 绘制,而控制层则负责作为中转控制连接模型层和视图层。这样子的开发方式将一个 web 应用分成三个部分。

每个部分的代码量减少了,出现代码错误排错起来更方便。而且原先把控制视图的代码和控制逻辑的代码混合在一起,对于 UI 的调试不方便,也容易出现一些奇怪的错误(比如 java 的 servlet 中如果用页面流的方式输出 HTML 代码,不仅影响 servlet 的代码美观,HTML 代码中如果出现一些特殊符号(比如双引号)导致页面流提前结束,代码就会出错)。

这种将一个代码中不同功能进行模块拆分的方法,在软件工程中叫松耦合。从字面意思理解,就是降低功能和功能之间的耦合度,使一个功能在出错的时候不至于同时影响另一个功能。

在原本的 MVC 中,JSP 是负责动态生成 HTML 的。但在长期的编程中发现,有些页面在动态生成的 HTML 中有大部分数据是相同的,只有小部分数据是需要更新的,这时候的思路就从动态生成整个 HTML 页面转变成了使用静态页面再对小部分数据动态刷新。因此 Ajax 诞生了。Ajax 通过与服务器交互,获取需要动态生成的数据(以 json 或者 XML 进行传输),然后再通过 JavaScript 渲染在静态页面上,从而实现页面的生成。这样子后端就不再需要分配多余的资源给 JSP 动态生成页面了(每一个 JSP 其实都是一个特殊的 servlet,会占用服务器的资源)。于此同时,前后端也彻底分离,后端只需要负责使用 json 与前端进行交互即可,前端也只需要负责找后端获取数据渲染即可。使用 json 进行前后端的联系。这样的方式,是比传统 MVC 更松的耦合。

因为前后端是通过 json 的方式来进行数据联系,所以前后端的测试也变得更加简单。以往前后端要一起进行测试,现在使用 json 分离前后端,前端只需要使用静态的 json 就能对前端页面进行测试,而后端只需要测试生成的 json 是否符合要求即可。

3.restful api 怎么进行设计

RestFul (REpresentational State Transfer)风格目标: 用来规范资源解释方式 与操作规则。

传统 URL 资源定义弊端

- 通过的 URL 没有统一的规范,将动词与名字合并,且很难通过 URL 资源定向标记,了解具体的业务意义

- 当不规范的 URL 随着在大型的项目中带来的问题是难以管理与维护

- 每个人对资源规则有独特的理解,那么真正的标准是什么,众多的规范,识别度底,最终干脆随心所欲,随后资源标签就腐化了

RestFul 作用

- 每一个 URI 代表一种资源

- 通过统一的标准风格规范来约束资源的表达方式,它结构清晰、符合标准、易于理解、扩展方便,所以正得到越来越多网站的采用

- 过四个 HTTP 动词,对服务器端资源进行操作,实现"表现层状态转化"

(一) 优点:

- 它是面向资源的(名词)

- 通过 URL 就知道需要什么资源

- 通过 Http Method(get/post...)就知道针对资源干什么

- 通过 Http Status Code 就知道结果如何

(二) 优点解释:

(1)通过 URL 就知道需要什么资源:表示 Restful 风格的 API 可以直接通过 URL 就可以看到需要操作的是什么资源,有语义化。

(2)Restful 风格的 API 是面向资源(名称)的,既 URL 中不会带相应的动词,针对资源的操作是通过 Http Method(既:post-增、delete-删、put-改(一般是提供实体的全部信息)、patch-改(修改实体的某些属性)、get-查)来实现的。

(3)通过 Http Status Code 就知道结果如何: 如常见的 200(成功)、400(错误的请求参数)、500(服务器错误)等。

接口规范

1、动作

GET (SELECT):从服务器检索特定资源,或资源列表。POST (CREATE):在服务器上创建一个新的资源。PUT (UPDATE):更新服务器上的资源,提供整个资源。PATCH (UPDATE):更新服务器上的资源,仅提供更改的属性。DELETE (DELETE):从服务器删除资源。

首先是四个半种动作:post、delete、put/patch、get 因为 put/patch 只能算作一类,所以将 patch 归为半个。

另外还有有两个较少知名的 HTTP 动词:HEAD - 检索有关资源的元数据,例如数据的哈希或上次更新时间。OPTIONS - 检索关于客户端被允许对资源做什么的信息。

2、路径(接口命名)

路径又称"终点"(endpoint),表示 API 的具体网址。

在 RESTful 架构中,每个网址代表一种资源(resource),所以网址中不能有动词,只能有名词,而且所用的名词往往与数据库的表格名对应。一般来说,数据库中的表都是同种记录的"集合"(collection),所以 API 中的名词也应该使用复数。

举例来说,有一个 API 提供动物园(zoo)的信息,还包括各种动物和雇员的信息,则它的路径应该设计成下面这样。

接口尽量使用名词,禁止使用动词,下面是一些例子。

GET /zoos:列出所有动物园

POST /zoos:新建一个动物园

GET /zoos/ID:获取某个指定动物园的信息

PUT /zoos/ID:更新某个指定动物园的信息(提供该动物园的全部信息)

PATCH /zoos/ID:更新某个指定动物园的信息(提供该动物园的部分信息)

DELETE /zoos/ID:删除某个动物园

GET /zoos/ID/animals:列出某个指定动物园的所有动物

DELETE /zoos/ID/animals/ID:删除某个指定动物园的指定动物

反例:

/getAllCars

/createNewCar

/deleteAllRedCars

再比如,某个 URI 是/posts/show/1,其中 show 是动词,这个 URI 就设计错了,正确的写法应该是/posts/1,然后用 GET 方法表示 show。

如果某些动作是 HTTP 动词表示不了的,你就应该把动作做成一种资源。比如网上汇款,从账户 1 向账户 2 汇款 500 元,错误的 URI 是:

POST /accounts/1/transfer/500/to/2

正确的写法是把动词 transfer 改成名词 transaction,资源不能是动词,但是可以是一种服务:

POST /transaction HTTP/1.1

Host: 127.0.0.1

from=1&to=2&amount=500.00

理清资源的层次结构,比如业务针对的范围是学校,那么学校会是一级资源(/school),老师(/school/teachers),学生(/school/students)就是二级资源。

3、版本(Versioning)

应该将 API 的版本号放入 URL。如:

https://api.example.com/v1/

另一种做法是,将版本号放在 HTTP 头信息中,但不如放入 URL 方便和直观。Github 采用这种做法。

4、过滤信息(Filtering)

如果记录数量很多,服务器不可能都将它们返回给用户。API 应该提供参数,过滤返回结果。下面是一些常见的参数。

?limit=10:指定返回记录的数量

?offset=10:指定返回记录的开始位置。

?page_number=2&page_size=100:指定第几页,以及每页的记录数。

?sortby=name&order=asc:指定返回结果按照哪个属性排序,以及排序顺序。

?animal_type_id=1:指定筛选条件

参数的设计允许存在冗余,即允许API路径和URL参数偶尔有重复。比如,

GET /zoo/ID/animals 与 GET /animals?zoo_id=ID 的含义是相同的。

5、状态码(Status Codes)

状态码范围

1xx 信息,请求收到,继续处理。范围保留用于底层HTTP的东西,你很可能永远也用不到。

2xx 成功,行为被成功地接受、理解和采纳

3xx 重定向,为了完成请求,必须进一步执行的动作

4xx 客户端错误,请求包含语法错误或者请求无法实现。范围保留用于响应客户端做出的错误,例如。他们提供不良数据或要求不存在的东西。这些请求应该是幂等的,而不是更改服务器的状态。

5xx 范围的状态码是保留给服务器端错误用的。这些错误常常是从底层的函数抛出来的,甚至

开发人员也通常没法处理,发送这类状态码的目的以确保客户端获得某种响应。

当收到5xx响应时,客户端不可能知道服务器的状态,所以这类状态码是要尽可能的避免。

服务器向用户返回的状态码和提示信息,常见的有以下一些(方括号中是该状态码对应的 HTTP 动词)。

200 OK - [GET]:服务器成功返回用户请求的数据,该操作是幂等的(Idempotent)。

201 CREATED - [POST/PUT/PATCH]:用户新建或修改数据成功。

202 Accepted - [*]:表示一个请求已经进入后台排队(异步任务)

204 NO CONTENT - [DELETE]:用户删除数据成功。

400 INVALID REQUEST - [POST/PUT/PATCH]:用户发出的请求有错误,服务器没有进行新建或修改数据的操作,该操作是幂等的。

401 Unauthorized - [*]:表示用户没有权限(令牌、用户名、密码错误)。

403 Forbidden - [*] 表示用户得到授权(与401错误相对),但是访问是被禁止的。

404 NOT FOUND - [*]:用户发出的请求针对的是不存在的记录,服务器没有进行操作,该操作是幂等的。

406 Not Acceptable - [GET]:用户请求的格式不可得(比如用户请求JSON格式,但是只有XML格式)。

410 Gone -[GET]:用户请求的资源被永久删除,且不会再得到的。

422 Unprocesable entity - [POST/PUT/PATCH] 当创建一个对象时,发生一个验证错误。

500 INTERNAL SERVER ERROR - [*]:服务器发生错误,用户将无法判断发出的请求是否成功。

502 网关错误

503 Service Unavailable

504 网关超时

4.RESTful 架构与 RPC 架构

在RESTful架构中,关注点在于资源,操作资源时使用标准方法检索并操作信息片段,在RPC架构中,关注点在于方法,调用方法时将像调用本地方法一样调用服务器的方法。

RESTful 架构

REST即表述性状态传递Representational State Transfer,是一种软件架构风格,也可以称作是一种设计API的模式,REST通过HTTP协议定义的通用动词方法GET、POST、PUT、DELETE,以URI对网络资源进行唯一标识,响应端根据请求端的不同需求,通过无状态通信,对其请求的资源进行表述,符合REST设计规范的架构就称为RESTful架构。

主要原则

- 网络上的所有事物都被抽象为资源

- 每个资源都有一个唯一的资源标识符

- 对资源的各种操作不会改变资源标识符

- 所有的操作都是无状态的

- 同一个资源具有多种表现形式如

xml、json等

统一资源接口

安全性是指访问REST接口时不会对服务端资源状态发生改变。

幂等性是指对于同一REST接口的URI多次访问时,得到的资源状态是相同的。

GET: 安全的,幂等的,用于读取资源POST: 不安全的,不幂等的,用于服务端自动产生的实例号创建资源,更新部分资源PUT: 不安全的,幂等的,用于客户端的实例号创建资源,更新资源DELETE: 不安全的,幂等的,用于客户端实例号删除资源

实例

- 查询

user,GET https://127.0.0.1/user/1,通过直接携带params查询用户 - 新增

user,POST https://127.0.0.1/user,请求body附带用户注册信息 - 修改

user,PUT https://127.0.0.1/user,请求body附带userid标识信息 - 删除

user,DELETE https://127.0.0.1/user,请求body附带userid标识信息 - 通过请求头

Accept来获取同一资源的不同形式,如application/json与application/xml等 - 若将版本号看作同一资源的不同表现形式的话,同样应该在

Accept字段来区分版本而不是直接在URI中添加版本号

RPC 架构

RPC即远程过程调用Remote Procedure Call,简单的理解是一个节点请求另一个节点提供的服务,远程过程调用,是相对于本地过程调用来说的,当调用方法时就像调用本地方法一样调用远程服务器的方法,做到了轻量、无感知通信。

结构组成

- 客户端

client:服务的调用方 - 服务端

server:服务的提供方 - 客户端存根

client stub:将客户端请求参数打包成网络消息,再发给服务方 - 服务端存根

server stub:接收客户端发来的消息,将消息解包,并调用本地方法

通信过程

客户端

- 将这个调用映射为 Call Id

- 将这个 Call Id 与参数等序列化,以二进制形式打包

- 将序列化数据包通过网络通信发送到服务端

- 等待服务端响应

- 服务端调用成功并返回结果,反序列化后进行下一步操作

服务端

- 在本地维护一个 Call Id 的 Map,用以保证 Id 与调用方法的对应

- 等待客户端请求

- 得到一个请求后,将数据包反序列化,得到 Call Id 与参数等

- 通过 Map 寻找 Call Id 所对应的函数指针

- 通过函数指针调用函数,并将数据包反序列化后的参数传递,得到结果

- 将结果序列化之后通过网络通信返回到客户端

注: 此处的客户端指的是本地调用者,也可以是一台服务器 此处的服务端指的是被调用者,也可以是一台服务器 数据包通信时无论是使用 socket 进行 TCP 传输,或使用 HTTP 进行传输都是可行的 Copy to clipboardErrorCopied

相关比较

- 在通信协议方面来说,

RESTful是使用HTTP协议进行数据传输,RPC一般是使用TCP协议数据传输,当然传输协议并不是RPC的重点,一般使用TCP协议传输是因为其效率高,使用HTTP协议传输是完全可行的。 - 在性能方面,

RPC的传输效率高于RESTful数据传输的效率,因为RCP具有高效紧凑的进程通信机制,且传输数据量小,在交换大量消息时效率高。 - 在灵活度方面,

RESTful架构的灵活度高于RPC架构,使用RESTful架构具有比较好的可读性,RPC在编写与调试时略显繁琐。 - 使用

RESTful架构的接口进行数据传输可以得到多语言支持,HTTP协议相对更规范、更通用、更标准,对于中间件而言最先支持的几种协议都包含RESTful数据传输规范。 - 内部服务的相互调用推荐使用

RPC,而对外的接口推荐使用RESTful,例如微服务架构模式一般就采用对内RPC对外RESTful的模式。

前端工具

脚手架 cli

当你使用 vue-cli 时, 你有没有想过什么?一起来实现一个精简版吧

命令注册

通过npm init生成你的package.json文件, 在里面加入 bin

"bin": {

"xxx": "bin/index.js"

},

这样, 当你全局装包的时候才会把你xxx命令注册到环境变量中。

接下来就是bin/index.js的事了。

使用commander完成命令行中的命令

program

.command("init [project-name]")

.description("create a project")

.option("-c, --clone", `it will clone from ${tmpUrl}`)

.option("--offline", "use cached template")

.action(function (name, options) {

console.log('we are try to create "%s"....', name);

downloadAndGenerate(name, options);

})

.on("--help", function () {

console.log("");

console.log("Examples:");

console.log("");

console.log(" $ masoneast init my-project");

console.log(` $ path: ${home}`);

});

program.parse(process.argv);

通过上面代码, 你就有了init命令, 和clone, offline参数了, 此时你就有了:

$ masoneast init my-project

$ masoneast init my-project --clone

$ masoneast init my-project --offline

关于commander包的具体使用, 可以看这里: commander

实现下载和 clone 模板

这里你需要有有个模板的地址供你下载和 clone, 如果你只是玩玩的话也可以直接使用vue提供的模板地址, 或者我的模板地址: 模板

下载实现代码:

这里依赖了两个库: git-clone和download。

function download(name, clone, fn) {

if (clone) {

gitclone(tmpUrl, tmpPath, (err) => {

if (err) fn(err);

rm(tmpPath + "/.git");

fn();

});

} else {

const url = tmpUrl.replace(/\.git*/, "") + "/archive/master.zip";

console.log(url);

downloadUrl(url, tmpPath, {

extract: true,

strip: 1,

mode: "666",

headers: { accept: "application/zip" },

})

.then(function (data) {

fn();

})

.catch(function (err) {

fn(err);

});

}

}

实现询问交互

交互的实现, 主要依赖了inquirer库。

function askQuestion(prompts) {

//询问交互

return (files, metalsmith, done) => {

async.eachSeries(

Object.keys(prompts),

(key, next) => {

prompt(metalsmith.metadata(), key, prompts[key], next);

},

done

);

};

}

将询问得到的答案存贮起来, 留给后面渲染使用

function prompt(data, key, prompt, done) {

//将用户操作存储到metaData中

inquirer

.prompt([

{

type: prompt.type,

name: key,

message: prompt.message || prompt.label || key,

default: prompt.default,

choices: prompt.choices || [],

validate: prompt.validate || (() => true),

},

])

.then((answers) => {

if (Array.isArray(answers[key])) {

data[key] = {};

answers[key].forEach((multiChoiceAnswer) => {

data[key][multiChoiceAnswer] = true;

});

} else if (typeof answers[key] === "string") {

data[key] = answers[key].replace(/"/g, '\\"');

} else {

data[key] = answers[key];

}

done();

})

.catch(done);

}

实现模板渲染

模板渲染, 依赖了前端模板引擎handlebar和解析模板引擎的consolidate库。 上面看到的vue-template模板里的{{#router}}其实就是handlebar的语法。

function renderTemplateFiles() {

return (files, metalsmith, done) => {

const keys = Object.keys(files);

const metalsmithMetadata = metalsmith.metadata(); //之前用户操作后的数据存在这里面

async.each(

keys,

(file, next) => {

//对模板进行遍历, 找到需要渲染内容的文件

const str = files[file].contents.toString();

if (!/{{([^{}]+)}}/g.test(str)) {

//正则匹配文件内容, 如果没有就不需要修改文件, 直接去往下一个

return next();

}

render(str, metalsmithMetadata, (err, res) => {

if (err) {

err.message = `[${file}] ${err.message}`;

return next(err);

}

files[file].contents = new Buffer(res);

next();

});

},

done

);

};

}

复制代码;

实现将文件从本地写到你的项目目录中

这里用到了一个核心库: metalsmith。它主要功能就是读取你的文件, 并通过一系列的中间件对你的文件进行处理, 然后写到你想要的路径中去。就是通过这个库, 将我们的各个流程串联起来, 实现对模板的改造, 写出你想要的项目。

metalsmith

.use(askQuestion(options.prompts)) //这一段是generator的精华, 通过各种中间件对用户选择的模板进行处理

.use(filterFiles(options.filters)) //文件筛选过滤

.use(renderTemplateFiles()) //模板内部变量渲染

.source(".")

.destination(projectPath) //项目创建的路径

.build((err, files) => {

if (err) console.log(err);

});

我这里实现的 demo 就是vue-cli的精简版, 主要功能有:

- 1.从 git 上 download 和 clone 项目模板

- 2.保存模板到本地,方便离线使用

- 3.询问问题, 按用户需求定制模板

前端包管理工具

npm 和 yarn

早期的 npm

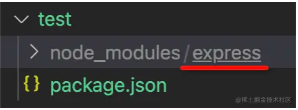

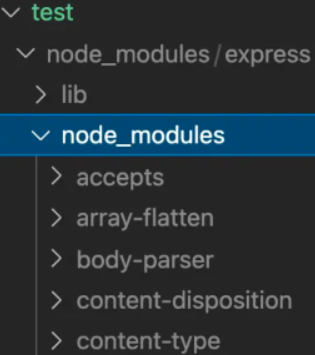

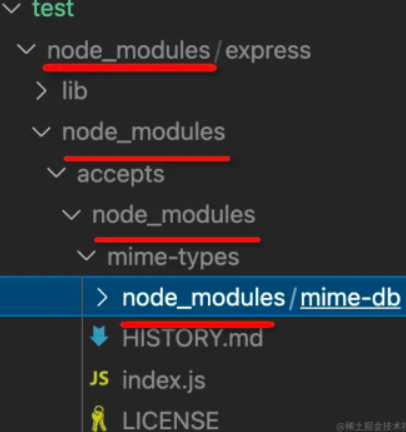

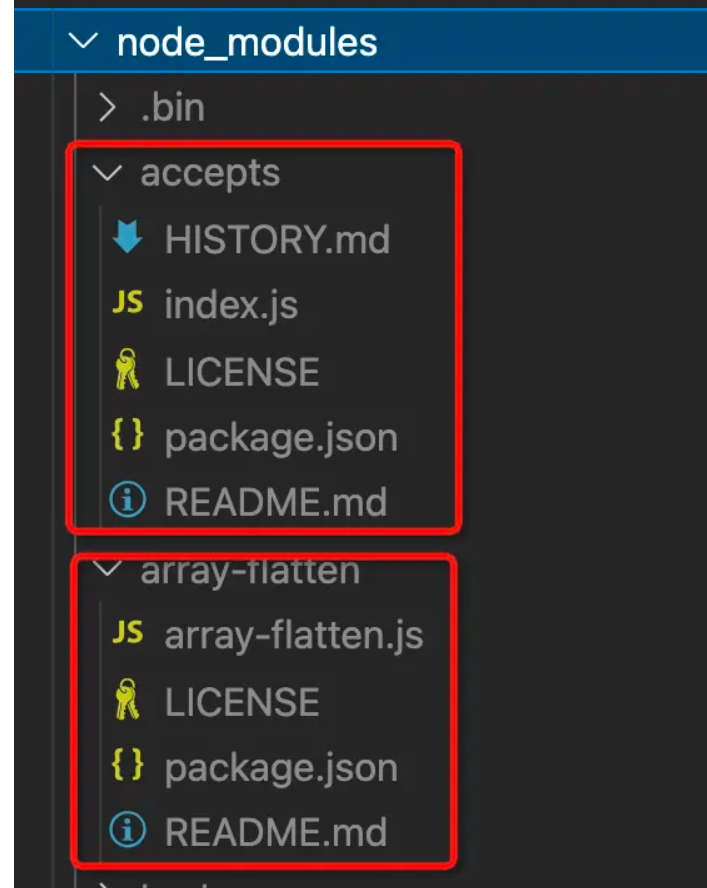

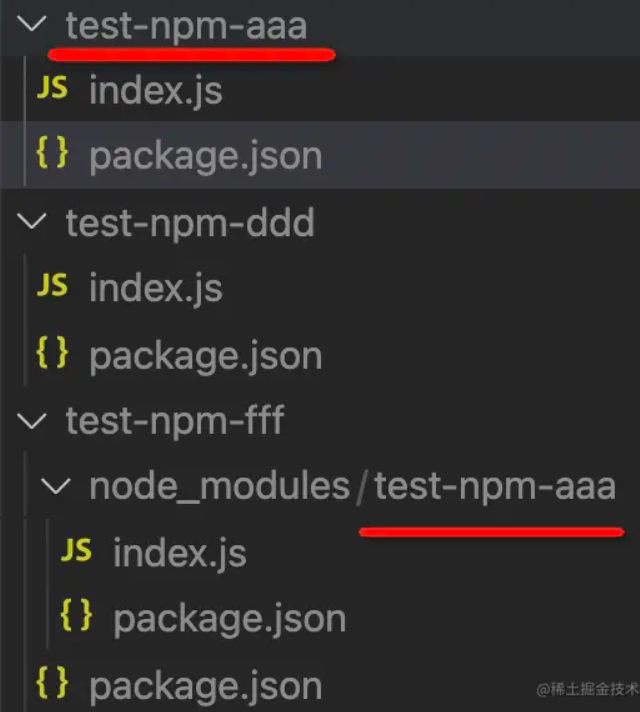

其实在最早期的npm版本(npm v2),npm的设计可以说是非常的简单,在安装依赖的时候会将依赖放到 node_modules文件中; 同时,如果某个直接依赖 A 依赖于其他的依赖包 B,那么依赖 B 会作为间接依赖,安装到依赖 A 的文件夹node_modules中,然后可能多个包之间也会有出现同样的依赖递归的,如果项目一旦过大,那么必然会形成一棵巨大的依赖树,依赖包会出现重复,形成嵌套地狱。

那么我们如何去理解"嵌套地狱"呢?

- 首先,项目的依赖树的层级过于深,如果有问题不利于排查和调试

- 在依赖的分支中,可能会出现同样版本的相互依赖的问题

那么这样的重复问题会带来什么后果呢?

- 首先,会使得安装的结果占据了大量的空间资源,造成了资源的浪费

- 同时,因为安装的依赖重复,会造成在安装依赖时,安装时间过长

- 甚至是,因为目录层级过深,导致文件路径过长,会在

windows系统下删除node_modules文件,出现删除不掉的情况

那么, 后面的版本是如何一步步进行优化的呢?后面会陆续的揭晓。

npm 的安装机制和核心原理

我们可以先来看看 npm 的核心目标

Bring the best of open source to you, your team and your company.

意思是 给你和你的团队、你的公司带来最好的开源库和依赖。 通过这句话,我们可以了解到 npm 最重要的一点就是安装和维护依赖。那么,让我们先来看一看npm的安装机制是怎样的呢?

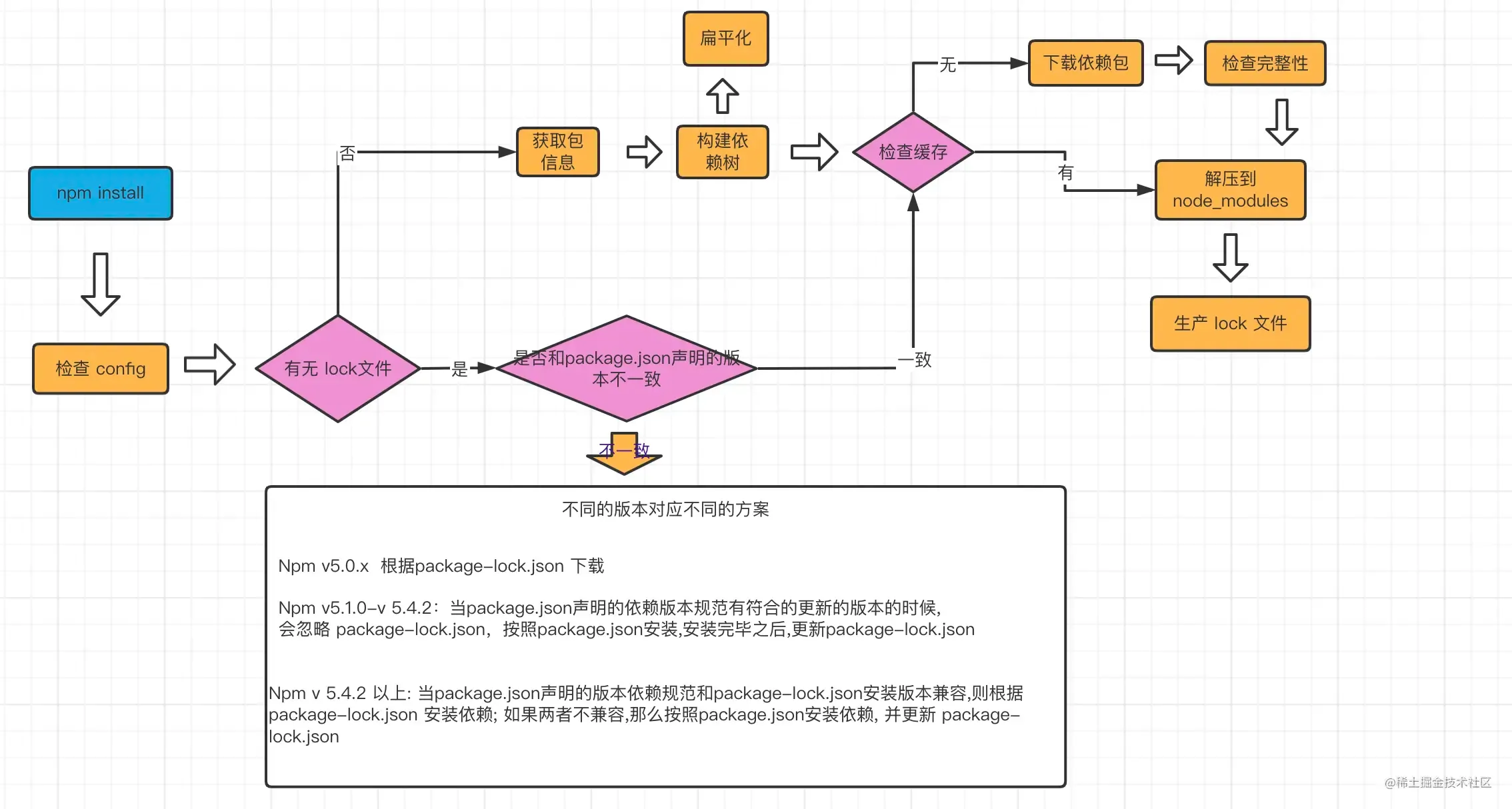

npm 的安装机制

下面我们会通过一个流程图来具体学习npm install的安装机制

npm install执行之后, 首先会检查和获取 npm的配置,这里的优先级为:

项目级的.npmrc文件 > 用户级的 .npmrc文件 > 全局级的 .npmrc > npm内置的 .npmrc 文件

然后检查项目中是否有 package-lock.json文件

- 如果有, 检查

package-lock.json和package.json声明的依赖是否一致:- 一致, 直接使用

package-lock.json中的信息,从网络或者缓存中加载依赖 - 不一致, 根据上述流程中的不同版本进行处理

- 一致, 直接使用

- 如果没有, 那么会根据

package.json递归构建依赖树,然后就会根据构建好的依赖去下载完整的依赖资源,在下载的时候,会检查有没有相关的资源缓存:- 存在, 直接解压到

node_modules文件中 - 不存在, 从 npm 远端仓库下载包,校验包的完整性,同时添加到缓存中,解压到

node_modules中

- 存在, 直接解压到

最后, 生成 package-lock.json 文件

其实, 在我们实际的项目开发中,使用 npm 作为团队的最佳实践: 同一个项目团队,应该保持npm 版本的一致性。

从上面的安装流程,不知道大家注意到了一点没有,在实际的项目开发中,如果每次都去安装对应依赖时,如果相关的依赖包体积过大或者是依赖于网络,无疑会增加安装的时间成本;那么,缓存在这里的就是一个解决问题的好办法,后面我们会做具体的介绍。

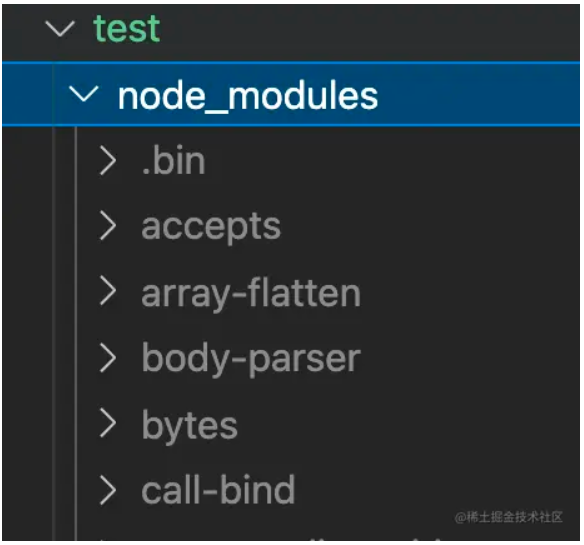

yarn 的出现

yarn 是一个由Facebook、Google、Exponent和Tilde构建的新的 JavaScript 包管理器。它的出现是为了解决历史上npm的某些不足(比如 npm 对于依赖的完整性和一致性的保证,以及 npm 安装过程中速度很慢的问题)

当 npm 还处于v3时期的时候,一个叫yarn的包管理工具横空出世.在 2016 年, npm 还没有 package-lock.json 文件,安装的时候速度很慢,稳定性很差,yarn的出现很好的解决了一下的一些问题:

- 确定性: 通过 yarn.lock 等机制,即使是不同的安装顺序,相同的依赖关系在任何的环境和容器中,都可以以相同的方式安装。(那么,此时的 npm v5 之前,并没有 package-lock.json 机制,只有默认并不会使用 npm-shrinkwrap.json)

- 采用模块扁平化的安装模式: 将不同版本的依赖包,按照一定的策略,归结为单个版本;以避免创建多个版本造成工程的冗余(目前版本的 npm 也有相同的优化)

- 网络性能更好:

yarn采用了请求排队的理念,类似于并发池连接,能够更好的利用网络资源;同时也引入了一种安装失败的重试机制 - 采用缓存机制,实现了离线模式 (目前的 npm 也有类似的实现)

我们可以来看一下 yarn.lock的结构:

"@babel/cli@^7.1.6", "@babel/cli@^7.5.5":

version "7.8.4"

resolved "http://npm.in.zhihu.com/@babel%2fcli/-/cli-7.8.4.tgz#505fb053721a98777b2b175323ea4f090b7d3c1c"

integrity sha1-UF+wU3IamHd7KxdTI+pPCQt9PBw=

dependencies:

commander "^4.0.1"

convert-source-map "^1.1.0"

fs-readdir-recursive "^1.1.0"

glob "^7.0.0"

lodash "^4.17.13"

make-dir "^2.1.0"

slash "^2.0.0"

source-map "^0.5.0"

optionalDependencies:

chokidar "^2.1.8"

熟悉 npm 的package-lock.json文件的朋友,可能一眼就看到了一些不同; package-lock.json采用的是JSON的结构,而yarn并没有采用这种结构,而是一种自定义的标记方式;我们可以看出新的自定义的方式,也同样保持了高度的可读性。

相比于 npm,Yarn 另一个显著的区别就是 yarn.lock 的子依赖的版本不是固定的版本。这其实就说明了一个问题: 一个单独的yarn.lock的问题并不能确定 ✅node-modules的文件结构,还需要package.json的配合。

其实到了这里,我会有一个问题,如何实现 npm 到 yarn 的切换呢?

这里 我了解到有一个专门的工具synp,它可以将yarn.lock转换为package-lock.json,反之亦然。

这里可以顺带提一嘴,yarn默认采用的是perfer-online模式,即优先使用网络资源。如果网络资源请求失败,再去请求缓存数据。

到这里我们应该对yarn有了初步的了解,那我们继续去看一下它的安装机制

yarn 的安装机制

上面一小节我们对 npm 的安装机制有了一些基本的了解,现在让我们先来简单的看一下Yarn的安装理念。

简单来说, Yarn的安装大致分为 5 个步骤:

检测(checking) ---> 解析包(Resolving Packages) ---> 获取包(Fetching) ---> 链接包(Linking Packages) ---> 构建包(Building Packages)

那么接下来我们要开始具体分析这些过程中都做了哪些事情:

检测包

这一步,最主要的目的就是检测我们的项目中是否存在 npm 相关的文件,比如package-lock.json等;如果有,就会有相关的提示用户注意:这些文件可能会存在冲突。在这一步骤中 也会检测系统 OS, CPU 等信息。

解析包

这一步会解析依赖树中的每一个包的信息:

首先呢,获取到首层依赖: 也就是我们当前所处的项目中的package.json定义的dependencies、devDependencies、optionalDependencies的内容。

紧接着会采用遍历首层依赖的方式来获取包的依赖信息,以及递归查找每个依赖下嵌套依赖的版本信息,并将解析过的包和正在进行解析包呢用Set数据结构进行存储,这样就可以保证同一版本范围内的包不会进行重复的解析:

举个例子

- 对于没有解析过的包 A, 首次尝试从

yarn.lock中获取版本信息,并且标记为已解析 - 如果在

yarn.lock中没有找到包 A, 则向Registry发起请求获取满足版本范围内的已知的最高版本的包信息,获取之后将该包标记为已解析。

总之,经过解析包这一步之后呢,我们就已经确定了解析包的具体版本信息和包的下载地址。

获取包

这一步首先我们会检查缓存中是否有当前依赖的包,同时呢将缓存中不存在的包下载到缓存的目录中。但是这里有一个小问题需要大家思考一下:

比如: 如何去判断缓存中有当前的依赖包呢?

其实呢,在 Yarn 中会根据 cacheFolder+slug+node_modules+pkg.name 生成一个路径;判断系统中是否存在该 path,如果存在证明已经有缓存,不用重新下载。这个 path 也就是依赖包缓存的具体路径。

那么对于没有命中的缓存包呢?在 Yarn 中存在一个 Fetch 队列,按照具体的规则进行网络请求。如果下载的包是一个 file 协议,或者是相对路径,就说明指向一个本地目录,此时会调用 Fetch From Local 从离线缓存中获取包;否则调用 Fetch From External 获取包,最终获取的结果使用 fs.createWriteStream 写入到缓存目录。

链接包

我们上一步已经把依赖放到了缓存目录,那么下一步,我们应该要做什么事情呢?是不是应该把项目中的依赖复制到node_modules目录下呢,没错;只不过此时需要遵循一个扁平化的原则。复制依赖之前, Yarn会先解析 peerDepdencies,如果找不到符合要求的peerDepdencies的包,会有 warning提示,并最终拷贝依赖到项目中。

构建包

如果依赖包中存在二进制包需要进行编译,那么会在这一步进行。

千呼万唤始出来,这里要插一句话,感谢大家的捧场。 为伊消得人憔悴,最近想的事情比较多,一直拖着实在是不好意思。那我们大家继续来一起整理:

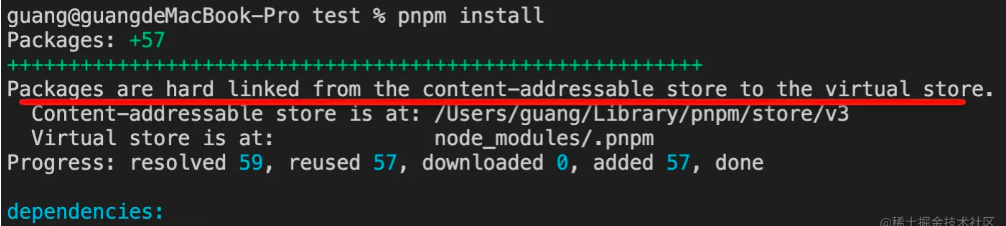

其实, 从大家的评论中我去认真讨论和学到了一些新的东西pnmp和Lerna;之后如果时间充裕的话,我也会去研究研究和大伙一起讨论的,感谢大家伙的支持 💗。

npm 的缓存机制

回归正题,接下来让我们看来一下 npm的对于同一个版本的依赖包是如何进行本地化缓存的

这是 npm 查看本地缓存的命令:

npm config get cache

复制代码

从图中我们可以看出 npm 配置缓存的位置在 /Users/zhaoxxxx/.npm(mac os 的默认的缓存的位置)当中。

其实你也看到了_cacache的目录有三个文件:

- content-v2

- index-v5

- tmp

其中, content-v2 里面存放的是一些二进制的文件。为了使二进制的文件可读,我把文件做了压缩和解压缩处理。

然后把下面的文件进行解压处理就可以得到我们想要的 npm 的具体的资源:

压缩结果

这里推荐一个 the unarchiver 解压缩工具,支持更多的格式,强力推荐。

而在 index-v5 文件中呢, 我们使用和刚才一样的操作可以得到一些描述性的文件。

事实上这些内容就是 content-v2 文件的索引。

那么这里我也有一个问题这里的缓存是如何存储并且被利用的呢?

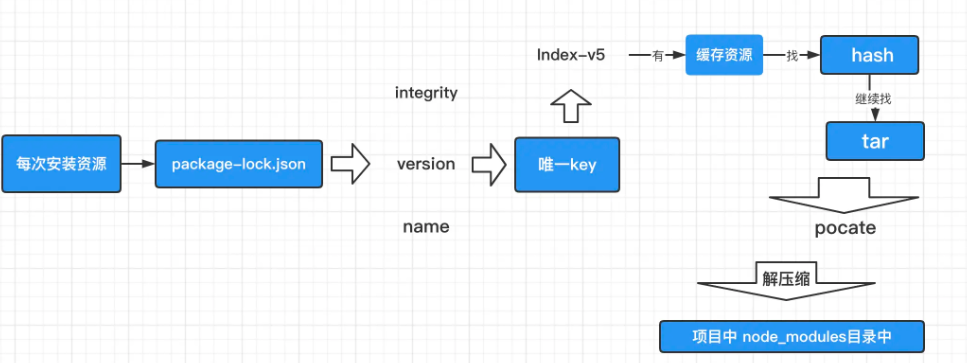

这里就要提一下 npm install的安装机制, 当 npm 执行的时候,通过 pacote 把相应的包解压到对应的 node_modules下面。(这里顺嘴提一句 pacote感兴趣的可以来一起研究一下细节,我目前有点不太能看懂; 大概的思路是结合网络请求和文件读写配置进行本地的缓存写入和生成对应的压缩文件,这里通过对一位大佬文章学习有所得)

npm 主要有会有三个地方用到 pacote:

- 当你执行 npm install xxx (这时候会通过

pacote.extract把对应的包解压到对应的node_modules下面,pacote源码地址: extract.js) - 当你执行 npm cache add xxx (这时候会通过

pacote.tarball 下的 tarballStream往我们之前看到的_cacache文件下去添加缓存,pacote源码地址: tarballStream) - 当你执行 npm pack xxx 通过

pacote.tarball 下的 _toFile在当前路径生成对应的压缩文件, 源码地址:_toFile )

当npm下载依赖的时候, 先下载到缓存当中,再解压到我们的项目的 node_modules中。 其实 pacote是依赖 npm-registry-fetch来下载包, npm-registry-fetch 可以通过设置 cache 字段进行相关的缓存工作。

紧接着呢, 我们在每次去安装资源的时候,会根据package-lock.json中的

- integrity

- verison

- name

integrity、verison、name 相关信息会生成一个唯一的 key;这个 key 就能够对应上 index-v5 目录下的缓存记录; 如果发现有缓存资源,就会去找到 tar 包对应的hash值. 根据 hash再去找缓存中的tar包,然后再次通过 pacote将二进制文件解压缩进我们项目的 node_modules目录中,这样就省去了资源下载的网络开销。

这里需要注意的是, 这里的缓存策略是在 npm v5 开始的,那么在 v5 之前呢, 每个缓存模块是在我们之前提到的 ~./npmrc 文件中以模块名的格式直接存储的

存储的格式:{cache}{name}{version}

npm or yarn 开发中的一点疑惑

你在实际的开发会不会出现这样的一些情况

- 当你项目依赖出现问题的时候, 我们会不会是直接删除

node_modules 和 lockfiles依赖, 再重新npm install,删除大法是否真的好用?这样的使用方案会不会带来什么问题? - 把所有的依赖包都安装到

dependencies中,对devDependencies不区分会不会有问题? - 一个项目中, 你使用

yarn, 我使用npm,会不会有问题呢? - 还有一个问题,

lockfiles 文件我们提交代码的时候需不需要提交到仓库中呢?

为什么要 lockfiles,要不要提交 lockfiles 到仓库?

其实从前文中 我们已经知道了,npm 从v5开始, 增加了package-lock.json 文件。那么 package-lock.json文件的作用是什么呢? 锁定依赖的安装结构, 这么做的目的是为了保证在任意的机器上我们去执行npm install 都会得到完全相同的 node_modules安装结果。

这里其实我是有一个疑问的?为啥单一的 package.json 不能确定唯一的依赖树呢?

- 首先是不同版本的 npm 的安装依赖的策略和算法可能是不一样的

- npm install 将根据

package.json中的 semver-range version 更新依赖,可能某些依赖自上次安装以后,己经发布了新的版本。

因此, 保证能够完整准确的还原项目依赖 就是lockfiles出现的原因。

首先我们这里需要了解一下 package-lock.json的作用机制。 举个例子:

"@babel/core": {

"version": "7.2.0",

"integrity": "sha1-pN04FJAZmOkzQPAIbphn/voWOto=",

"dev": true,

"requires": {

"@babel/code-frame": "^7.0.0",

// ...

},

"dependencies": {

"@babel/generator": {

"version": "7.2.0",

"resolved": "http://www.npm.com/@babel%2fgenerator/-/generator-7.2.0.tgz",

"integrity": "sha1-6vOCH6AwHZ1K74jmPUvMGbc7oWw=",

"dev": true,

"requires": {

"@babel/types": "^7.2.0",

"jsesc": "^2.5.1",

"lodash": "^4.17.10",

"source-map": "^0.5.0",

"trim-right": "^1.0.1"

}

},

// ...

}

},

// ...

}

那么, 通过上面的示例, 我们可以看到: 一个 package-lock.json 的 dependency 主要是有以下的几部分组成的:

- Version: 依赖包的版本号

- Resolved: 依赖包的安装源(其实就是可以理解为下载地址)

- Intergrity: 表明完整性的 Hash 值

- Dev: 表示该模块是否为顶级模块的开发依赖或者是一个的传递依赖关系

- requires: 依赖包所需要的所有依赖项,对应依赖包 package.json 里 dependencices 中的依赖项

- dependencices: 依赖包 node_modeles 中依赖的包(特殊情况下才存在)

事实上, 并不是所有的子依赖都有 dependencies 属性,只有子依赖的依赖和当前已安装在根目录的 node_modules 中的依赖冲突之后, 才会有这个属性。 这可能涉及嵌套情况的依赖管理,大家找些资料看看。

至于我们要不要提交 lockfiles 到仓库中? 这个就需要看我们具体的项目的定位了。

- 如果是开发一个应用, 我的理解是

package-lock.json文件提交到代码版本仓库.这样可以保证项目中成员、运维部署成员或者是 CI 系统, 在执行npm install后, 保证在不同的节点能得到完全一致的依赖安装的内容 - 如果你的目标是开发一个给外部环境用的库,那么就需要认真考虑一下了, 因为库文件一般都是被其他项目依赖的,在不使用 package-lock.json 的情况下,就可以复用主项目已经加载过的包,减少依赖重复和体积

- 如果说我们开发的库依赖了一个精确版本号的模块, 那么在我们去提交 lockfiles 到仓库中可能就会出现, 同一个依赖被不同版本都被下载的情况。如果我们作为一个库的开发者, 其实如果真的使用到某个特定的版本依赖的需求, 那么定义peerDependencies 是一个更好的选择。

所以, 我个人比较推荐的一个做法是:把 package-lock.json一起提交到仓库中去, 不需要 ignore. 但是在执行 npm publish 命令的时候,也就是发布一个库的时候, 它其实应该是被忽略的不应该被发布出去的。

当然,我这里了解到对 lockfiles的处理,可能需要一个更加细颗粒度的理解,这里我会推荐大家去结合前文去理解。

- 在 npm 早期所用到的锁定版本的方式是通过使用

npm-shrinkwrap.json, 它与之前我们提到的package-lock.json最大的不同之处在于: npm 包发布的时候默认是将npm-shrinkwrap.json发布的, 因此类库和组件需要慎重。 - 我们在可以使用到

package-lock.json是在 npm v5.x 版本新增的特性,而在 npm v5.6 之后才趋于逐步稳定的状态, 在 5.0 - 5.6 中间, 其实是对package-lock.json的处理逻辑进行过几次更新。 - 在 npm v5.0.x 版本中, npm install 时都会根据 package-lock.json 文件下载,不管你的

package.json的内容究竟是什么。 - npm v5.1.0 版本到 npm v5.4.2, npm install 会无视

package-lock.json文件下载的, 会去下载最新版本的 npm 包,并且会更新package-lock.json. - npm 5.4.2 版本之后呢,我们继续细化分析:

- 如果在我们的实际开发的项目中, 只有

package.json文件时, npm install 之后, 会根据它生成一个package-lock.json文件 - 如果在项目中存在了

package.json和package-lock.json文件, 同时package.json的semver-range 版本 和package-lock.json中版本兼容,即使此时会有新的适用的版本,npm install还是会根据package-lock.json下载的 - 如果在项目中存在了

package.json和package-lock.json文件, 同时package.json的semver-range 版本 和package-lock.json中版本不兼容,npm install会把package-lock.json更新到兼容package.json的版本。 - 如果

package-lock.json和npm-shrinkwrap.json同时存在于项目的根目录中的时候,package-lock.json将会被忽略的。

- 如果在我们的实际开发的项目中, 只有

对于上面的过程分析,我之前的文章中做了一个过程的流程图的分析,大家可以结合前文做一个更加精细化的理解

那么,下面我们继续来看下一个问题, 我们不管是使用 npm 或 yarn 都有可能会把包依赖安装到不同的依赖模块中, 你有没有去思考为什么会这样做呢?这么做会有什么必要关系和我们之后的开发和发布?

为什么会有 xxxDependencies?

其实, npm 设计了以下的几种依赖类型声明:

- dependencies 项目依赖

- devDependencies 开发依赖

- peerDependencies 同版本的依赖

- bundledDependencies 捆绑依赖

- optionalDependencies 可选依赖

它们起到的作用和声明意义是各不相同的。下面我们来具体介绍一下:

dependencies 表示项目依赖,这些依赖都会成为你的线上生产环境中的代码组成的部分。当 它关联到 npm 包被下载的时候, dependencies下的模块也会作为依赖, 一起被下载。

devDependencies表示开发依赖, 不会被自动下载的。因为 devDependencies 一般是用于开发阶段起作用或是只能用于开发环境中被用到的。 比如说我们用到的 Webpack,预处理器 babel-loader、scss-loader,测试工具E2E等, 这些都相当于是辅助的工具包, 无需在生产环境被使用到的。

这里有一点还是需要我去啰嗦一下的,并不是只有在dependencies中的模块才会被一起打包, 而是在 devDependencies 中的依赖一定不会被打包的。 实际上, 依赖是否是被打包,完全是取决你的项目里的是否是被引入了该模块。

peerDependencies 表示同版本的依赖, 简单一点说就是: 如果你已经安装我了, 那么你最好也安装我对应的依赖。 这里举个小例子: 加入我们需要开发一个react-ui 就是一个基于react 开发的 UI 组件库, 它本身是会需要一个宿主环境去运行的, 这个宿主环境还需要指定的 react版本来搭配使用的, 所以需要我们去 package.json中去配置:

"peerDependencies": {

"React": "^17.0.0"

}

bundledDependencies 和 npm pack 打包命令有关。假设我们在 package.json中有如下的配置:

{

"name": "test",

"version": "1.0.0",

"dependencies": {

"dep": "^0.0.2",

...

},

"devDependencies": {

...

"devD1": "^1.0.0"

},

"bundledDependencies": [

"bundleD1",

"bundleD2"

]

}

那我们此时执行 npm pack的时候, 就会生成一个 test-1.0.0.tgz的压缩包, 在该压缩包中还包含了 bundleD1和 bundleD2 两个安装包。 实际使用到 这个压缩包的时候

npm install test-1.0.0.tgz 的命令时, bundleD1和 bundleD2 也会被安装的。

这里其实也有需要注意的是: 在 bundledDependencies 中指定的依赖包, 必须先在dependencies 和 devDependencies 声明过, 否则 npm pack 阶段是会报错的。